利用注視點

(中國AI網 2025年07月04日)實例分割對于增強現實和虛擬現實至關重要,因為它可以實現精確的對象識別和交互,增強虛擬和現實元素的集成,幫助實現身臨其境的體驗。然而,分割的高計算開銷限制了其在資源受限的AR/VR設備的應用,造成了較大的處理延遲,降低了用戶體驗。

與傳統場景相比,AR/VR用戶在轉換視角之前通常只關注視場內的幾個區域,所以可以將分割集中在特定的注視區域。這種洞察力推動了對高效分割方法的需求,優先處理感興趣的實例,減少計算負載并增強實時性能。在一項研究中,紐約大學和Meta團隊提出了一個注視點實例分割框架FovealSeg,利用實時用戶注視數據專門針對感興趣的實例執行實例分割,從而節省了大量的計算。評價結果表明,FSNet在ADE20K和LVIS的IoU分別為0.56和0.54,明顯優于基線。

語義分割是計算機視覺的一項基本任務,涉及將圖像劃分為有意義的區域,以方便對其視覺內容的分析和解釋。實例分割通過識別和描繪圖像中的每個單獨對象實例進一步實現了這一點,而這在增強現實中起著關鍵作用,因為它可以在現實世界場景中實現精確的對象識別和分離,允許更準確的交互,以實現身臨其境和上下文感知的用戶體驗。

盡管分割任務非常重要,但它帶來了大量的計算挑戰,特別是在資源有限的AR/VR設備,主要是由于設備捕獲的輸入圖像的高分辨率。例如,Meta Ray-Ban眼鏡有一個1200萬像素的攝像頭,能夠錄制1440P的視頻,這在實例分割過程中會導致大量的計算開銷。如此高的數據量導致相當大的計算延遲,并可能嚴重限制性能和響應能力,最終通過阻礙實時交互和流動性降低整體用戶體驗。

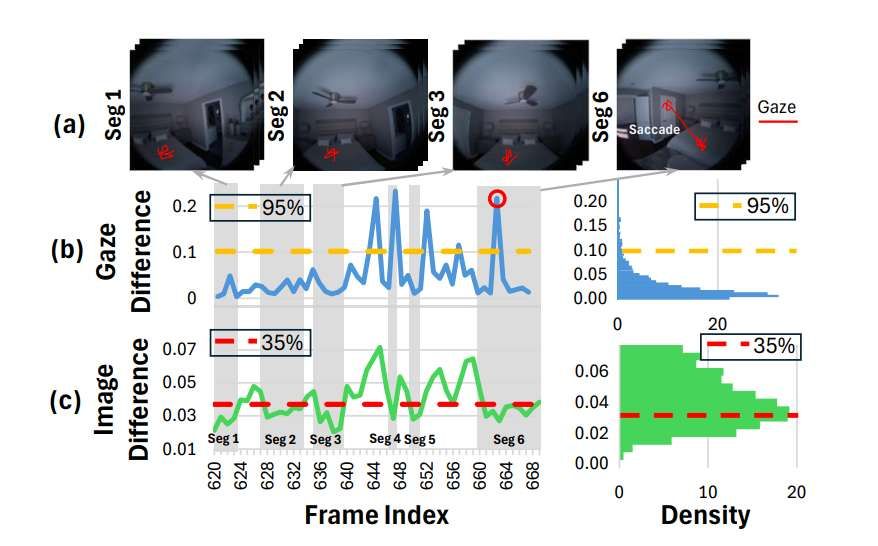

與傳統用例相比,AR/VR設備用戶有一個獨特的行為:他們傾向于只關注一個視圖中的特定小區域,然后再切換到另一個視圖。如圖1所示,用戶戴著AR眼鏡站在臥室里。在圖1 (a)的左邊部分,用戶看了幾秒鐘床,然后轉過頭去看衣柜,如圖1 (a)的右邊部分所示。

在這種情況下,連續的視頻幀可以根據頭部運動分為兩段。在第一段中,幀高度相似,注視主要集中在床上,允許只在床上執行實例分割。同樣,在第二段中,注視集中在衣柜。這種洞察力為AR/VR環境中的實例分割提供了一種固有的高效解決方案,通過根據用戶的注視確定感興趣實例(IOI)的處理優先級。

將計算資源集中在目標區域,可以顯著減少處理工作量和計算成本,增強AR/VR應用程序的實時性能,并改善整體用戶體驗。這與注視點渲染的范例自然一致,通過僅在用戶注視區域以全分辨率渲染圖像來增強圖形性能,同時減少周邊視覺中的細節以節省計算資源。

在研究中,紐約大學和Meta團隊提出了一種新的實例分割方法,注視點實例分割,通過采用注視點處理策略,僅在人類注視所在的實例上進行分割,從而消除了對整個圖像進行處理的需要。盡管這種方法具有提高效率的巨大潛力,但它同時存在挑戰。第一個挑戰是設計一個深度神經網絡(DNN)框架,只處理與注視位置相關的IOI。第二個挑戰是利用人類注視的時間動態,進一步減少冗余計算,提高處理效率。

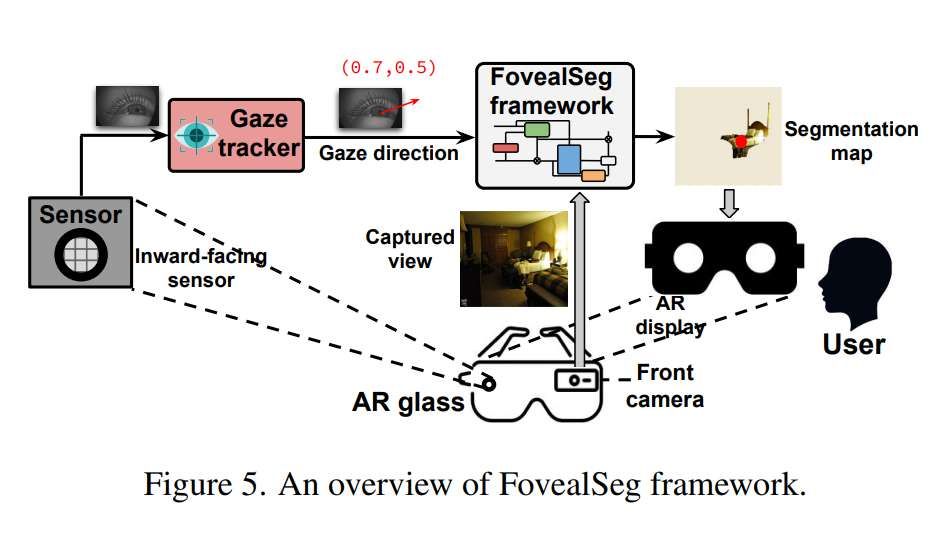

圖5展示了FovealSeg框架的計算流程。在操作過程中,AR/VR設備的朝內傳感器連續捕獲用戶眼睛的圖像并將其發送給注視追蹤器,注視追蹤器在大約5-10毫秒內估計出高精度的注視方向。然后將估計的注視方向連同從前置攝像頭捕獲的高分辨率圖像作為額外輸入一起傳遞給FovealSeg。接下來,FovealSeg生成一個僅關注IOI的分割圖,并在具有相似注視位置的幀之間重用。

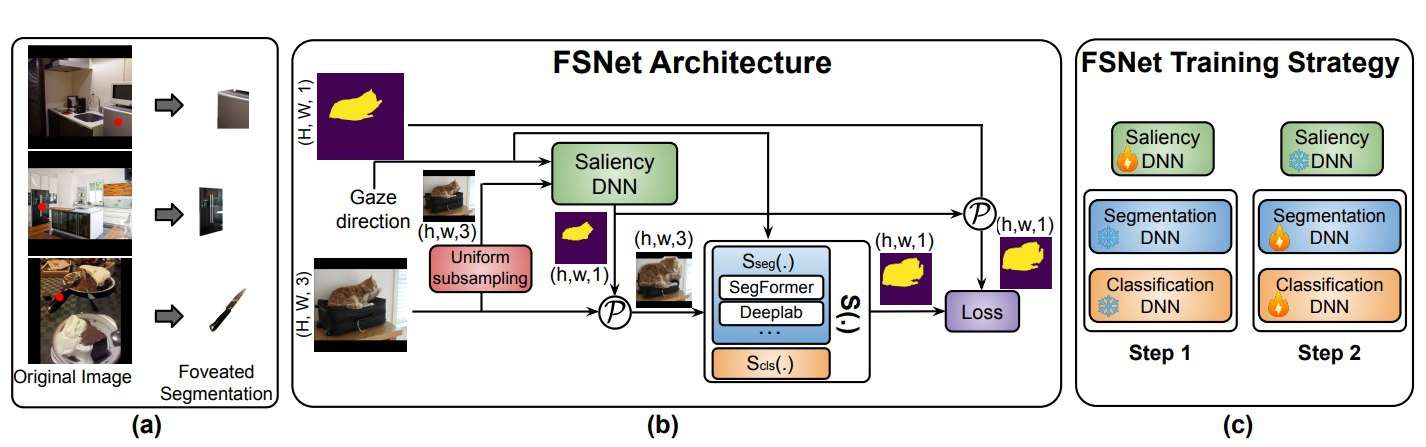

如圖6 (a)所示,注視點分割專注于僅為IOI生成實例分割掩碼。因此,它需要創建一個二進制掩碼來識別IOI區域及其相關的類標簽。這與傳統的分割方法不同。現有方法難以利用注視位置作為先驗信息來指導分割,使得區分不同類別的前景和背景的任務變得復雜。另外,常用的分割損失函數,如標準關節損失和焦點損失,在目標實例特別小的情況下,往往無法進行微調。為了解決所述問題,團隊引入了FSNet,它包含注視感知模型架構和優化的訓練和微調策略。

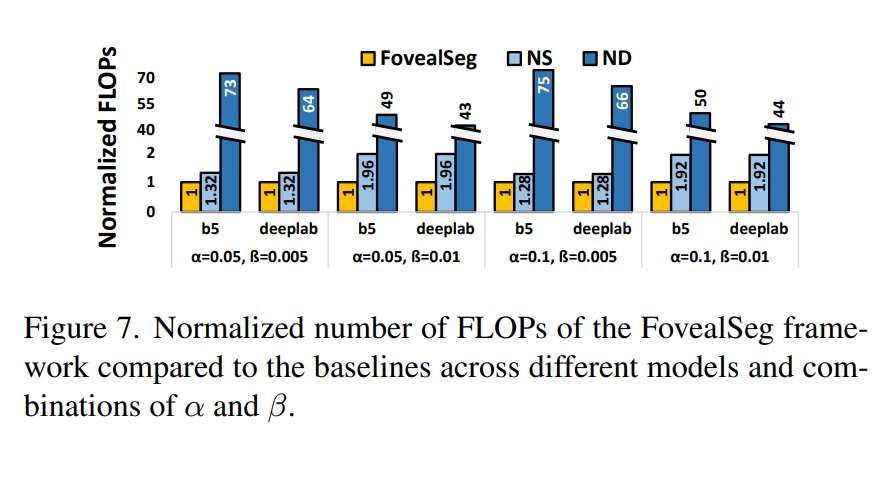

圖7中的結果突出了與基線相比,FovealSeg框架實現的增強計算效率。FovealSeg框架采用的高降采樣率減少了實例分割任務所需的計算量。利用注視掃視和注視可以消除大量的冗余計算,實現高達1.96倍的FLOPs降低。與ND相比,FovealSeg可以減少高達75倍的計算量,強調了降采樣對系統性能增強的重大貢獻。

團隊檢查了FSNet中降采樣率對性能的影響。表3給出了cityscape數據集降采樣圖像大小為F ’ 32×64時的FSNet性能。隨著降采樣率的增加,IoU和IoU’都呈現出明顯的下降,其中基于deeplab的FSNet的IoU從0.52下降到0.36。這種趨勢在所有基線方法中都是一致的。然而,即便在如此低的分辨率下,FSNet方法依然優于其他方法。

他們同時研究了高斯核大小如何影響性能,因為它在采樣過程中起著至關重要的作用。表4給出了cityscape數據集上的結果。結果表明,由于更強調注視信息的顯著區域影響,更大的核尺寸產生了更好的結果。在FSNet設計中,他們結合注視坐標(u, v)來指導FSNet對輸入圖像f進行采樣。

在表5中,我們通過用隨機噪點代替注視信息來評估FSNet在沒有注視信息的cityscape數據集上的性能。結果顯示IoU明顯減少了0.3以上,突出了注視位置信息在FSNet中的關鍵作用。

為了評估FovealSeg框架在現實世界中的效率,他們比較了FSNet+Seg-B5和SegFormer-B5,以評估速度和精度之間的權衡。如圖6所示,FSNet實現了84毫秒的延遲,比SegFormer-B5快20倍以上,后者需要1860毫秒。值得注意的是,FSNet同時提供了卓越的分割性能。它較低的延遲導致更好的時間對齊和更好的視覺體驗。

相關論文:Foveated Instance Segmentation

https://arxiv.org/pdf/2503.21854

總的來說,FovealSeg利用實時注視數據進行聚焦于IOI區域的實例分割。評估結果顯示,在不同的數據集上,性能得到了增強,效率同樣有了顯著提高。團隊表示,這為未來的研究奠定了基礎。