一個邊緣GPU插件模塊

(中國AI網 2025年07月11日)快速發展的增強現實和虛擬現實要求在資源受限的平臺進行實時、逼真的渲染。3D高斯飛濺在渲染效率和質量方面提供了最先進的(SOTA)性能,并已成為廣泛的AR/VR應用中有前途的解決方案之一。然而,盡管它在高端GPU表現出色,但在邊緣系統卻舉步維艱,每秒幀數僅為7-17幀,遠低于真正沉浸式AR/VR體驗所需的60幀以上標準。

為了解決這一挑戰,佐治亞理工學院團隊對基于高斯的AR/VR應用進行了全面分析,并確定了高斯混合階段(集中計算每個高斯在每個像素的貢獻)作為主要瓶頸。為此,他們提出了一個高斯混合單元(GBU),一個邊緣GPU插件模塊,以用于AR/VR應用的實時渲染。

值得注意的是,這個GBU可以無縫集成到傳統的邊緣GPU中,并協同支持廣泛的AR/VR應用。具體來說,GBU結合了行內順序著色(IRSS)數據流,利用兩步坐標變換,從左到右依次遮蔽每一行像素。當直接部署在GPU時,所提出的數據流在真實的靜態場景中實現了1.72倍的加速(但依然缺乏實時渲染性能)。

考慮到基于GPU的實現中有限的計算利用率,GBU使用專用的渲染引擎來提高渲染速度,通過聚合來自多個高斯的計算來平衡跨行工作負載。跨代表性AR/VR應用的實驗表明,GBU在保持SOTA渲染質量的同時,為設備的實時渲染提供了一個解決方案。

在大量行業興趣和投資的推動下,增強現實和虛擬現實正在迅速擴張。與頭顯一樣,邊緣AR/VR平臺致力于在虛擬會議、旅游和試用等各種應用中提供沉浸式和交互式體驗。相關應用需要實時、逼真地渲染由靜態和動態對象組成的場景,以及具有復雜姿勢和表情的人物化身。

因此,開發一個通用的渲染管道至關重要,以準確地重建各種現實世界的場景,并在邊緣AR/VR設備高效地執行。在圖形和計算機視覺社區,3D高斯飛濺已經成為AR/VR中非常有前途的3D場景表示。它實現了跨各種對象和場景的SOTA重建性能,并且在3D重建之外的AR/VR任務中表現出色,包括3D資產創建,場景編輯和開放詞匯查詢等等。

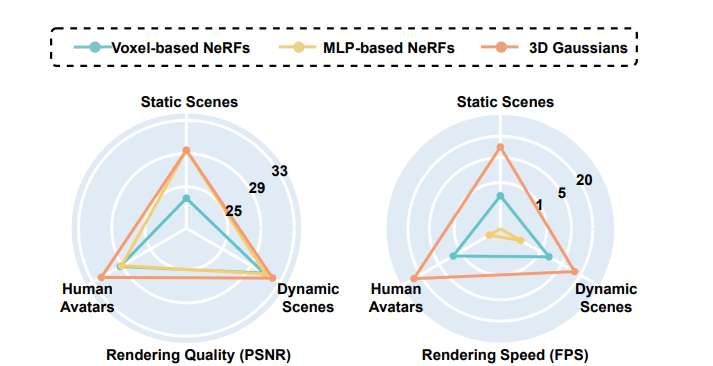

與之前的神經輻射場(NeRF)等表示相比,3D高斯表示具有更好的平衡性和更快的重建速度,并顯著提高了渲染幀率,如圖1所示。這使得3D高斯飛濺成為資源受限型AR/VR平臺中的3D應用程序的絕佳選擇(其中邊緣GPU是主要渲染硬件)。

盡管3D高斯函數在服務器和桌面設備具有實時渲染的潛力,但在邊緣設備的實時渲染(即≥60 FPS[54])依然存在顯著的性能差距。例如,在Jetson Orin NX(英偉達的邊緣GPU)渲染來自MipNeRF-360數據集的真實場景時,FPS只能達到7到17幀。這一差距阻礙了利用最新3D重建技術的新興AR/VR應用的采用。

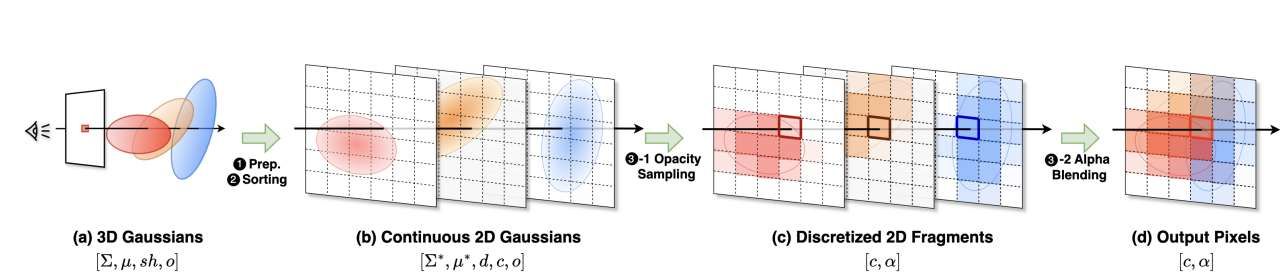

為了彌補這一差距,佐治亞理工學院對多個基于高斯的3D渲染管道進行了全面的分析,目標是高斯混合階段(集中計算每個高斯在每個像素的貢獻),因為它一直是主要的延遲瓶頸,占渲染時間的48%到78%。這一階段需要密集的逐像素處理,涉及多個矩陣向量乘法,并成為整體延遲的瓶頸。

為此,他們開發了高斯混合單元(GBU),這是一個為邊緣GPU設計的硬件模塊,可以使用3D高斯圖像進行實時渲染,增強AR/VR應用。所述單元與現有邊緣GPU順利集成,加速常見的渲染瓶頸,以提高跨各種應用程序的性能,其設計確保兼容性和可擴展性

為了理解基于高斯的渲染管道的典型加速瓶頸,研究人員分析了AR/VR平臺流行的基于高斯的重建算法。其中包括用于重建靜態場景的3D Gaussian Splatting,用于動態場景重建的4D Gaussian Splatting,以及用于人類化身動畫的Splatting Avatar。團隊的分析是使用實際數據集進行。

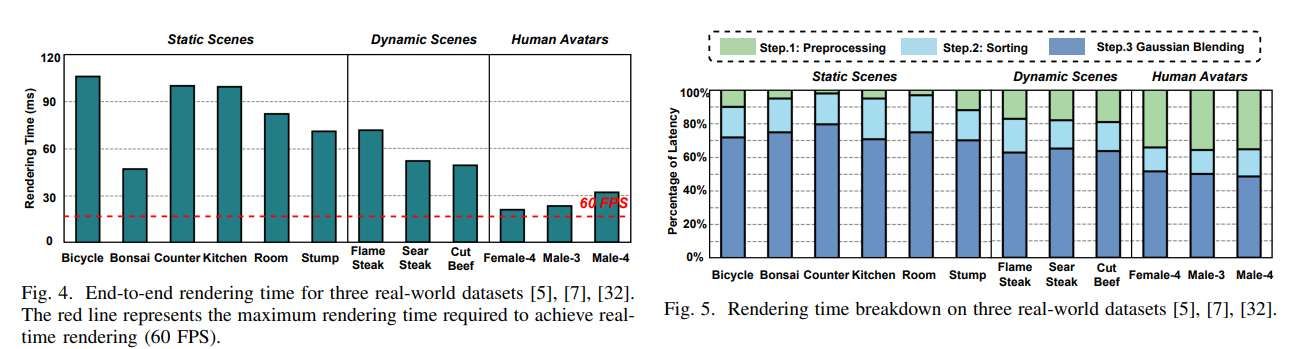

數據集的詳細統計信息在Tab 1中列出。他們在邊緣GPU設備Jetson Orin NX 16GB運行算法,并使用Nisight Systems進行內核級渲染時間分解。對于總體分析結果,他們將總體運行時間和相應的渲染時間分解為圖4和圖5所示的三個渲染階段。分析包含3種不同類型的12個真實世界場景:6個靜態場景,3個動態場景和3個人類化身。

團隊觀察到:

在邊緣GPU,三種場景都沒有達到實時渲染性能。這主要是由于渲染步驟中的延遲瓶頸。例如,在現實世界的靜態場景中,這一步占整體渲染時間的70%到78%;

在動態場景和可動畫角色的渲染中,盡管由于建模運動和變形的預處理步驟更加復雜,渲染步驟的比例有所增加,但渲染步驟依然是主要的瓶頸,在動態場景中占62% ~ 65%,在人物角色動畫中占48% ~ 51%;

渲染步驟,包括排序過程,同時消耗了所有三種類型場景的渲染時間的相當部分,從14%到24%不等。

至于與獨立加速器的比較,團隊將提議的GBU與獨立的3D高斯和神經輻射場(NeRF)加速器進行基準測試。需要注意的是,GBU和獨立加速器不能直接進行比較,因為后者提供端到端加速,但通常只專注于一種類型的場景(例如靜態場景)。

相比之下,GBU只加速一個渲染步驟,并與各種AR/VR應用程序兼容。為了公平比較,他們創建了GBU的獨立版本,稱為GBU- standalone,并專門用于靜態場景渲染。GBU- standalone是通過將GBU與專用硬件模塊集成在一起構建。模塊的實現遵循GS-Core的剔除/轉換/排序單元的設計。

在相同的目標渲染速度下,以及Tanks&Temples數據集和Deep Blending數據集,GBU-Standalone顯示出優越的面積和能源效率。另外,由于先進的3D高斯渲染算法,GBU實現了最高的渲染質量,同時在渲染速度,面積效率和能耗方面優于先前的NeRF加速器,進一步驗證了所提出技術的有效性。

盡管GBU在三個廣泛使用的數據集中表現出強大的性能,但它可能在特定極端條件下面臨挑戰。例如,當camera離場景很遠時,高斯分布可能會覆蓋更少的像素,從而減少計算共享。例如在靜態場景數據集中,將camera到場景的距離增加4倍,可以將GBU在普通GPU的加速從原來的10.8倍降低到4.7倍。所以,未來的研究可以通過自適應地合并基于camera距離的高斯函數來解決這個問題。

另外,GBU主要加速渲染步驟,但在高度動態的場景中,其他渲染步驟可能會主導計算。例如,多角色設置可能需要在渲染步驟中進行大量的處理來建模人體,從而限制了GBU的整體加速。針對這個問題,一個專門用于渲染步驟的加速器可以在這種情況下提高效率。

相關論文:Gaussian Blending Unit: An Edge GPU Plug-in for Real-Time Gaussian-Based Rendering in AR/VR

https://arxiv.org/pdf/2503.23625

總的來說,由于與基于SOTA高斯的渲染管道相關的大量計算需求,在邊緣設備實現實時渲染速度依然是一個重大挑戰。在這項研究中,佐治亞理工學院團隊開發了GBU,一個專門為邊緣系統設計的硬件模塊。

所提出方法包括對AR/VR應用程序中的渲染管道進行全面分析,以確定性能瓶頸。其次,他們開發了一個專門的數據流,降低了計算成本。然后,研究人員共同設計了一個專用的硬件模塊,以無縫集成到現有的GPU架構中,從而提高數據的局部性,并利用高斯重用緩存來優化渲染過程。

對各種AR/VR應用的廣泛評估表明,GBU不僅解決了主要的延遲瓶頸,而且在保持SOTA渲染質量的同時支持廣泛的應用。結果證實了硬件軟件協同設計方法在彌合邊緣設備性能差距方面的有效性,為更具沉浸感和響應性的AR/VR體驗鋪平了道路。