人-物交互合成

(中國AI網(wǎng) 2025年07月03日)人-物交互(HOI)合成對于虛擬現(xiàn)實(shí)等多種應(yīng)用都非常重要。但由于其復(fù)雜性和高成本,獲取3D HOI數(shù)據(jù)具有挑戰(zhàn)性。在一項(xiàng)研究中,香港大學(xué),蘇黎世聯(lián)邦理工學(xué)院,斯坦福大學(xué)和騰訊團(tuán)隊(duì)提出了一種全新的zero shot HOI合成框架,不依賴于當(dāng)前有限的3D HOI數(shù)據(jù)集的端到端訓(xùn)練。

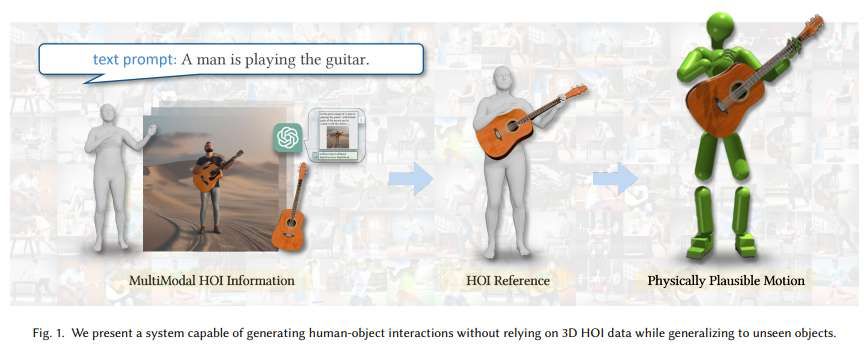

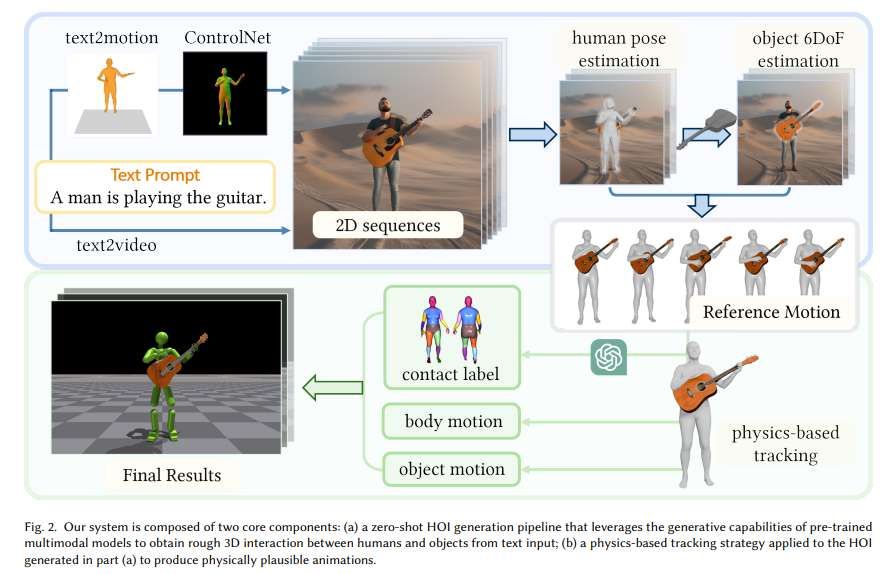

方法的核心思想在于利用來自預(yù)訓(xùn)練多模態(tài)模型的廣泛HOI知識(shí)。給定文本描述,系統(tǒng)首先使用圖像或視頻生成模型獲得時(shí)間一致的2D HOI圖像序列,然后將其提升到人類和物體姿態(tài)的3D HOI milestons。采用預(yù)訓(xùn)練的人體姿態(tài)估計(jì)模型提取人體姿態(tài),并引入可泛化category-level六自由度估計(jì)方法來從二維HOI圖像中獲取目標(biāo)姿態(tài)。估計(jì)方法適用于從文本到三維模型或在線檢索得到的各種對象模板。

基于物理的追蹤進(jìn)一步應(yīng)用于細(xì)化身體運(yùn)動(dòng)和物體姿態(tài),以產(chǎn)生更物理上可信的HOI生成結(jié)果。實(shí)驗(yàn)結(jié)果表明,所述方法能夠生成具有物理真實(shí)感和語義多樣性的開放詞匯HOI。

隨著擴(kuò)散模型的進(jìn)步,文本到運(yùn)動(dòng)生成框架在3D運(yùn)動(dòng)數(shù)據(jù)集進(jìn)行端到端訓(xùn)練已經(jīng)證明了合成多種運(yùn)動(dòng)序列的能力。然而,由于缺乏明確的人物交互建模,模型在生成逼真人物交互(HOI)序列方面面臨挑戰(zhàn)。另外,3D HOI數(shù)據(jù)集的有限可用性進(jìn)一步限制了HOI生成的端到端訓(xùn)練,限制了它們支持多種對象類型和交互模式的能力。

與獲取3D數(shù)據(jù)(尤其是3D HOI數(shù)據(jù)集)的成本和挑戰(zhàn)相比,2D圖像、視頻和文本數(shù)據(jù)要豐富得多,同時(shí)更容易獲取。受到DreamFusion等方法的啟發(fā),香港大學(xué),蘇黎世聯(lián)邦理工學(xué)院,斯坦福大學(xué)和騰訊團(tuán)隊(duì)探索將類似技術(shù)用于3D HOI生成。特別是ControlNet的發(fā)展大大提高了二維擴(kuò)散生成的可控性,使得能夠指定人體姿勢,并在文本描述的指導(dǎo)下生成相應(yīng)的二維HOI內(nèi)容。

研究人員提出了一種基于優(yōu)化的框架,用于使用預(yù)訓(xùn)練的多模態(tài)模型生成zero shot HOI。框架無需對當(dāng)前有限的3D HOI數(shù)據(jù)集進(jìn)行端到端訓(xùn)練,而且利用大型多模態(tài)模型中廣泛的HOI信息來促進(jìn)處理各種對象類型和運(yùn)動(dòng)模式。另外,他們集成了一個(gè)基于物理的模擬器,以改進(jìn)生成的HOI,使其在物理上合理。

給定文本描述,所提出方法能夠同時(shí)為人和物體產(chǎn)生相應(yīng)的運(yùn)動(dòng)。系統(tǒng)首先提取嵌入在最先進(jìn)的圖像和視頻生成模型中的現(xiàn)有2D人機(jī)交互(HOI)先驗(yàn),而它們專門用于生成時(shí)間一致的2D HOI圖像序列。隨后利用提取的2D HOI知識(shí)來提升人體姿勢和物體姿勢的3D HOI milestons。

他們使用預(yù)訓(xùn)練的人體姿態(tài)估計(jì)模型來獲得三維人體姿態(tài)。針對文本到3D模型生成的任意對象模板或使用輸入文本提示從在線資源獲取的任意對象模板,團(tuán)隊(duì)提出了一種可泛化的category-level六自由度估計(jì)方法,從生成的2D HOI圖像中提取對象姿態(tài)。

所述方法采用兩階段優(yōu)化過程來解決輸入對象模板和生成的2D HOI圖像之間潛在的幾何和外觀差異:通過使用語義對應(yīng)解決Perspective-n-Point (PnP)問題獲得初始粗估計(jì),然后使用可微渲染進(jìn)行細(xì)化階段。然后,在物理模擬環(huán)境中對身體運(yùn)動(dòng)和物體姿態(tài)的合成3D HOI milestons進(jìn)行基于物理的追蹤,從而產(chǎn)生一個(gè)物理合理的動(dòng)畫,準(zhǔn)確地描繪了手與物體的交互。

與在3D HOI數(shù)據(jù)上訓(xùn)練的其他HOI生成方法相比,所提出的zero shot生成框架利用了在更大規(guī)模數(shù)據(jù)集上訓(xùn)練的大型多模態(tài)模型中的廣泛2D, 3D和文本HOI信息。基于這一優(yōu)勢,這一方法適用于更多樣化的對象,并能夠生成更廣泛的HOI。通過在物理模擬環(huán)境中進(jìn)行細(xì)化,團(tuán)隊(duì)進(jìn)一步增強(qiáng)了生成的HOI的物理真實(shí)感。

與基線方法的比較評估表明,所提出方法在產(chǎn)生更現(xiàn)實(shí)和多樣化的HOI結(jié)果方面具有優(yōu)越的能力。另外,系統(tǒng)具有高度通用性,不僅能夠生成HOI,而且能夠用物體增強(qiáng)現(xiàn)有的ground truth人體運(yùn)動(dòng),從視頻片段中重建HOI,并可進(jìn)一步用于自動(dòng)生成3D HOI數(shù)據(jù)集。

相關(guān)論文:Zero-Shot Human-Object Interaction Synthesis with Multimodal Priors

https://arxiv.org/pdf/2503.20118

總的來說,團(tuán)隊(duì)提出了一種新的zero shot方法來生成人-物交互(HOI),不依賴于三維HOI數(shù)據(jù)集,從而解決了現(xiàn)有方法在對象多樣性和交互模式方面的局限性。系統(tǒng)利用來自預(yù)訓(xùn)練的多模態(tài)模型的現(xiàn)有HOI先驗(yàn)來生成粗略的3D HOI運(yùn)動(dòng)學(xué)運(yùn)動(dòng)。通過使用基于物理的追蹤策略細(xì)化運(yùn)動(dòng),并產(chǎn)生具有增強(qiáng)物理真實(shí)感的開放詞匯HOI。

結(jié)果證明了所提出方法在可擴(kuò)展和多樣化的HOI生成方面的潛力。當(dāng)然,目前的研究依然存在改進(jìn)的余地。首先,管道的性能和成功率明顯受到生成的HOI先驗(yàn)質(zhì)量的限制,例如2D圖像和視頻。較差的初始圖像生成可能導(dǎo)致后續(xù)階段的性能下降。其次,由于手部運(yùn)動(dòng)的復(fù)雜性,系統(tǒng)沒有明確地建模詳細(xì)的手部運(yùn)動(dòng),這限制了它處理復(fù)雜物體操作的能力。克服這一限制的一個(gè)潛在解決方案是采用GAIL框架來訓(xùn)練特定于手的鑒別器,允許更精確地處理手的交互,并顯著增強(qiáng)生成HOI的真實(shí)感。