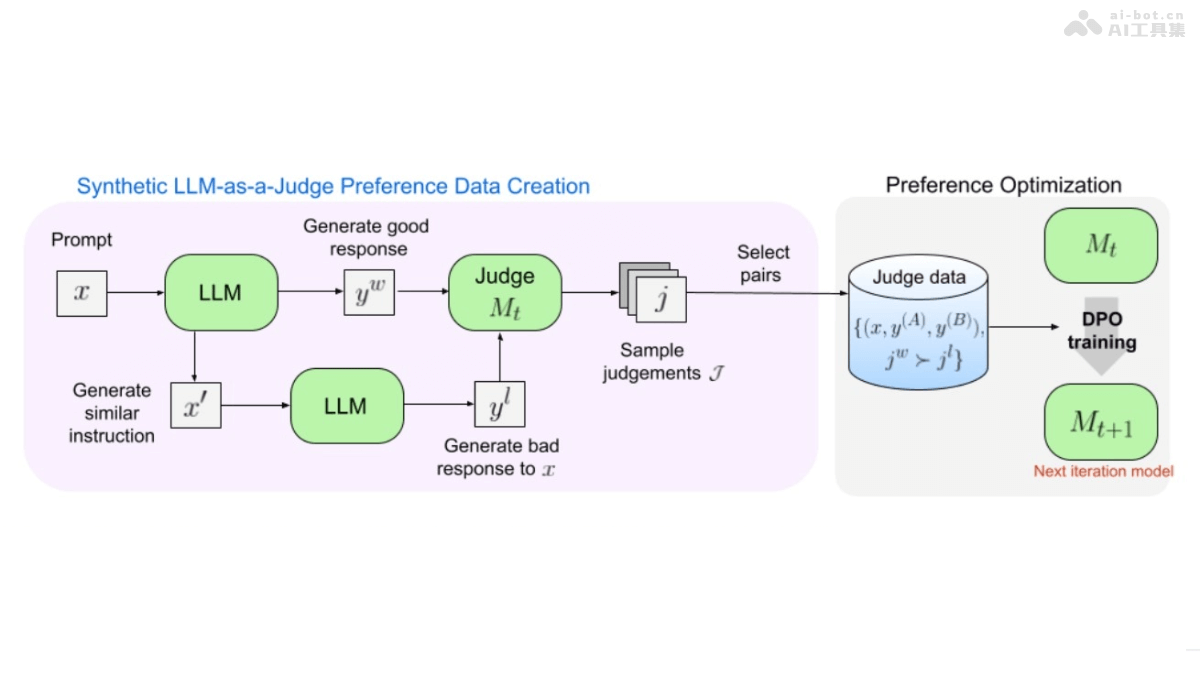

Self-Taught Evaluators是一種新型的模型評估方法,基于自我訓練的方式提高大型語言模型(LLM)的評估能力,無需人工標注數據。從未經標記的指令開始,用迭代自我改進方案生成對比模型輸出。用LLM作為裁判,生成推理軌跡和最終判斷。在每次迭代中重復,用改進的預測訓練模型。在實驗中,Self-Taught Evaluators提高基于Llama3-70B-Instruct模型的評估準確性,從75.4提高到88.3,在多數投票的情況下達到88.7,超越常用的LLM裁判如GPT-4,與用人工標注數據訓練的頂級獎勵模型性能相當。

Self-Taught Evaluators的主要功能生成對比模型輸出:從未經標記的指令開始,基于提示生成不同質量的模型響應對。訓練LLM作為裁判:用LLM生成推理軌跡和最終判斷,評估哪一響應更優。迭代自我改進:在每次迭代中用當前模型的判斷標注訓練數據,微調模型,實現自我改進。評估模型性能:在標準評估協議如RewardBench上評估模型的準確性,與人類評估結果進行比較。Self-Taught Evaluators的技術原理初始化:假設訪問大量人類編寫的用戶指令和一個初始的種子LLM。指令選擇:基于LLM對指令進行分類,選擇具有挑戰性和平衡分布的指令子集。響應對構建:為每個選定的指令生成偏好數據,包括兩個響應(優選和非優選),基于提示生成,確保非優選響應的質量低于優選響應。迭代訓練:包括判斷注釋和模型微調兩個步驟。用當前模型生成推理軌跡和判斷,如果判斷正確則將示例添加到訓練集中。用數據微調模型,為下一次迭代提供更新的模型。Self-Taught Evaluators的項目地址GitHub倉庫:https://github.com/facebookresearch/RAM/tree/main/projects/self_taught_evaluatorHuggingFace模型庫:https://huggingface.co/datasets/facebook/Self-taught-evaluator-DPO-dataarXiv技術論文:https://arxiv.org/pdf/2408.02666Self-Taught Evaluators的應用場景語言模型開發:在開發新型的大型語言模型(LLM)時,Self-Taught Evaluators評估和優化模型的輸出質量,確保模型生成的文本符合預期的標準。自動化內容評估:在內容生產領域,如新聞機構、出版業或社交媒體平臺,用在自動化評估內容的質量和準確性,提高內容審核的效率。教育和學術研究:在教育領域,Self-Taught Evaluators作為輔助工具,幫助評估學生的寫作作業或研究論文,提供反饋和改進建議。客服和技術支持:在客戶服務領域,用在評估自動回復系統的質量,確保回復既準確又有幫助,提升客戶滿意度。編程和代碼生成:對于需要代碼生成和評估的場景,Self-Taught Evaluators能評估生成的代碼片段的質量,幫助開發人員改進代碼。

Self-Taught Evaluators的主要功能生成對比模型輸出:從未經標記的指令開始,基于提示生成不同質量的模型響應對。訓練LLM作為裁判:用LLM生成推理軌跡和最終判斷,評估哪一響應更優。迭代自我改進:在每次迭代中用當前模型的判斷標注訓練數據,微調模型,實現自我改進。評估模型性能:在標準評估協議如RewardBench上評估模型的準確性,與人類評估結果進行比較。Self-Taught Evaluators的技術原理初始化:假設訪問大量人類編寫的用戶指令和一個初始的種子LLM。指令選擇:基于LLM對指令進行分類,選擇具有挑戰性和平衡分布的指令子集。響應對構建:為每個選定的指令生成偏好數據,包括兩個響應(優選和非優選),基于提示生成,確保非優選響應的質量低于優選響應。迭代訓練:包括判斷注釋和模型微調兩個步驟。用當前模型生成推理軌跡和判斷,如果判斷正確則將示例添加到訓練集中。用數據微調模型,為下一次迭代提供更新的模型。Self-Taught Evaluators的項目地址GitHub倉庫:https://github.com/facebookresearch/RAM/tree/main/projects/self_taught_evaluatorHuggingFace模型庫:https://huggingface.co/datasets/facebook/Self-taught-evaluator-DPO-dataarXiv技術論文:https://arxiv.org/pdf/2408.02666Self-Taught Evaluators的應用場景語言模型開發:在開發新型的大型語言模型(LLM)時,Self-Taught Evaluators評估和優化模型的輸出質量,確保模型生成的文本符合預期的標準。自動化內容評估:在內容生產領域,如新聞機構、出版業或社交媒體平臺,用在自動化評估內容的質量和準確性,提高內容審核的效率。教育和學術研究:在教育領域,Self-Taught Evaluators作為輔助工具,幫助評估學生的寫作作業或研究論文,提供反饋和改進建議。客服和技術支持:在客戶服務領域,用在評估自動回復系統的質量,確保回復既準確又有幫助,提升客戶滿意度。編程和代碼生成:對于需要代碼生成和評估的場景,Self-Taught Evaluators能評估生成的代碼片段的質量,幫助開發人員改進代碼。