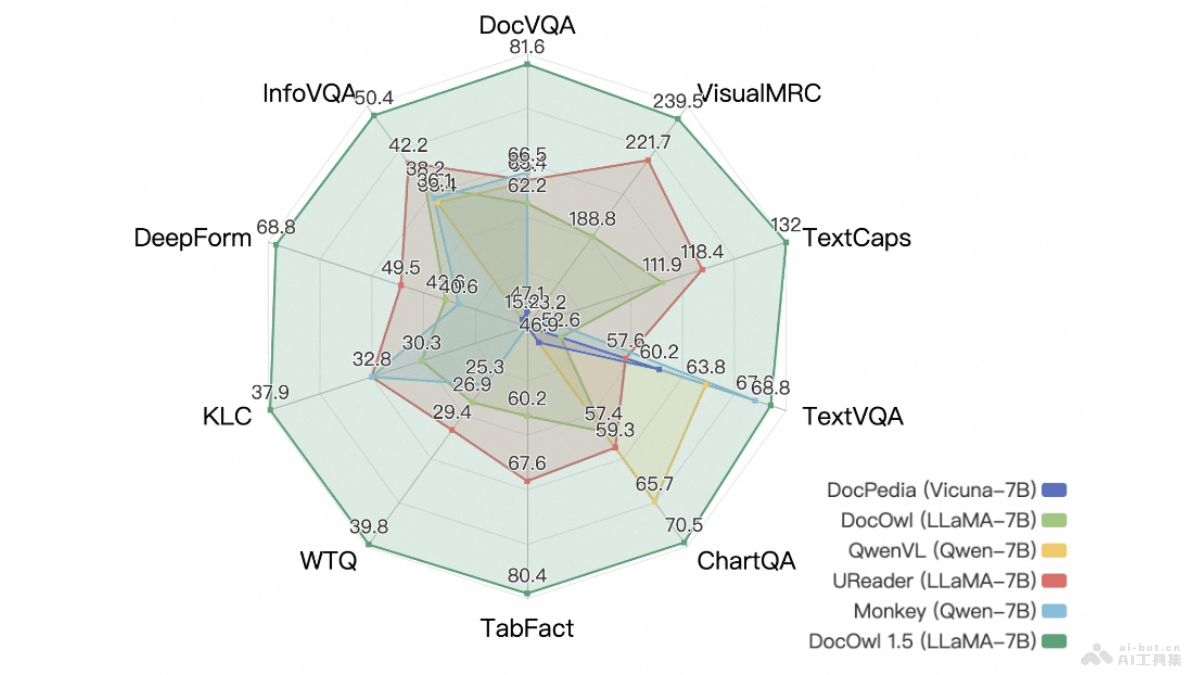

mPLUG-DocOwl 1.5是由阿里巴巴集團(tuán)推出的多模態(tài)大型語言模型,專注于OCR-free(無需光學(xué)字符識別)的文檔理解。模型基于統(tǒng)一結(jié)構(gòu)學(xué)習(xí),強(qiáng)化對文本豐富圖像如文檔、表格和圖表的結(jié)構(gòu)信息理解能力。mPLUG-DocOwl 1.5包含結(jié)構(gòu)感知解析任務(wù)和多粒度文本定位任務(wù),覆蓋五個(gè)領(lǐng)域:文檔、網(wǎng)頁、表格、圖表和自然圖像。mPLUG-DocOwl 1.5的H-Reducer模塊基于卷積層合并水平相鄰圖像塊,減少視覺特征長度,保持布局信息,讓模型能高效處理高分辨率圖像。在多個(gè)視覺文檔理解基準(zhǔn)測試中,模型展現(xiàn)業(yè)界領(lǐng)先的無OCR性能,提升SOTA性能超過10分。

mPLUG-DocOwl 1.5的主要功能結(jié)構(gòu)感知的文檔解析:識別和解析文檔中的文本結(jié)構(gòu),如換行和空格,理解文檔的組織方式。表格轉(zhuǎn)Markdown:將表格圖像轉(zhuǎn)換為Markdown格式,便于進(jìn)一步的處理和閱讀。圖表轉(zhuǎn)Markdown:將圖表圖像轉(zhuǎn)換為Markdown格式,保留圖表中的關(guān)鍵數(shù)據(jù)和結(jié)構(gòu)信息。自然圖像解析:對自然場景中的圖像進(jìn)行解析,識別和理解圖像中的文字信息。多粒度文本定位:在不同粒度級別(單詞、短語、行、塊)上定位文本,增強(qiáng)模型對文本位置的識別能力。mPLUG-DocOwl 1.5的技術(shù)原理統(tǒng)一結(jié)構(gòu)學(xué)習(xí)(Unified Structure Learning):基于結(jié)構(gòu)感知解析任務(wù)和多粒度文本定位任務(wù),模型學(xué)習(xí)如何理解和處理文本豐富的圖像。H-Reducer視覺-文本模塊:基于卷積層合并水平相鄰的視覺特征,減少特征長度,保持布局信息,讓大型語言模型能更有效地處理高分辨率圖像。多模態(tài)大型語言模型(MLLM):結(jié)合視覺編碼器和大型語言模型,用視覺到文本的模塊(如H-Reducer),讓模型理解和生成與視覺內(nèi)容相關(guān)的語言描述。大規(guī)模數(shù)據(jù)集訓(xùn)練:用大規(guī)模的標(biāo)注數(shù)據(jù)集,如DocStruct4M和DocReason25K,模型能學(xué)習(xí)各種文檔和圖像中的文本結(jié)構(gòu)和語義信息。兩階段訓(xùn)練框架:首先進(jìn)行統(tǒng)一結(jié)構(gòu)學(xué)習(xí),然后進(jìn)行多任務(wù)調(diào)整,讓模型在各種下游任務(wù)中能表現(xiàn)出色。mPLUG-DocOwl 1.5的項(xiàng)目地址GitHub倉庫:X-PLUG/mPLUG-DocOwl/tree/main/DocOwl1.5arXiv技術(shù)論文:https://arxiv.org/pdf/2403.12895mPLUG-DocOwl 1.5的應(yīng)用場景自動(dòng)化文檔處理:在企業(yè)或政府機(jī)構(gòu)中,自動(dòng)化解析和理解大量文檔,如合同、發(fā)票、報(bào)告和表格,提高工作效率和減少人工干預(yù)。智能搜索引擎:在搜索引擎中集成mPLUG-DocOwl 1.5,增強(qiáng)對圖像中文本內(nèi)容的搜索能力,提供更準(zhǔn)確的搜索結(jié)果。輔助閱讀和理解:幫助用戶更好地理解復(fù)雜文檔的內(nèi)容,尤其是對于視覺障礙人士,基于解析文檔結(jié)構(gòu)提供易于訪問的信息。教育和學(xué)術(shù)研究:在教育領(lǐng)域,輔助學(xué)生和研究人員理解教科書、學(xué)術(shù)論文和研究資料中的復(fù)雜信息。客戶服務(wù)和支持:在客戶服務(wù)系統(tǒng)中,用mPLUG-DocOwl 1.5解析用戶上傳的文檔,自動(dòng)提取關(guān)鍵信息,提供更快的服務(wù)響應(yīng)。

mPLUG-DocOwl 1.5的主要功能結(jié)構(gòu)感知的文檔解析:識別和解析文檔中的文本結(jié)構(gòu),如換行和空格,理解文檔的組織方式。表格轉(zhuǎn)Markdown:將表格圖像轉(zhuǎn)換為Markdown格式,便于進(jìn)一步的處理和閱讀。圖表轉(zhuǎn)Markdown:將圖表圖像轉(zhuǎn)換為Markdown格式,保留圖表中的關(guān)鍵數(shù)據(jù)和結(jié)構(gòu)信息。自然圖像解析:對自然場景中的圖像進(jìn)行解析,識別和理解圖像中的文字信息。多粒度文本定位:在不同粒度級別(單詞、短語、行、塊)上定位文本,增強(qiáng)模型對文本位置的識別能力。mPLUG-DocOwl 1.5的技術(shù)原理統(tǒng)一結(jié)構(gòu)學(xué)習(xí)(Unified Structure Learning):基于結(jié)構(gòu)感知解析任務(wù)和多粒度文本定位任務(wù),模型學(xué)習(xí)如何理解和處理文本豐富的圖像。H-Reducer視覺-文本模塊:基于卷積層合并水平相鄰的視覺特征,減少特征長度,保持布局信息,讓大型語言模型能更有效地處理高分辨率圖像。多模態(tài)大型語言模型(MLLM):結(jié)合視覺編碼器和大型語言模型,用視覺到文本的模塊(如H-Reducer),讓模型理解和生成與視覺內(nèi)容相關(guān)的語言描述。大規(guī)模數(shù)據(jù)集訓(xùn)練:用大規(guī)模的標(biāo)注數(shù)據(jù)集,如DocStruct4M和DocReason25K,模型能學(xué)習(xí)各種文檔和圖像中的文本結(jié)構(gòu)和語義信息。兩階段訓(xùn)練框架:首先進(jìn)行統(tǒng)一結(jié)構(gòu)學(xué)習(xí),然后進(jìn)行多任務(wù)調(diào)整,讓模型在各種下游任務(wù)中能表現(xiàn)出色。mPLUG-DocOwl 1.5的項(xiàng)目地址GitHub倉庫:X-PLUG/mPLUG-DocOwl/tree/main/DocOwl1.5arXiv技術(shù)論文:https://arxiv.org/pdf/2403.12895mPLUG-DocOwl 1.5的應(yīng)用場景自動(dòng)化文檔處理:在企業(yè)或政府機(jī)構(gòu)中,自動(dòng)化解析和理解大量文檔,如合同、發(fā)票、報(bào)告和表格,提高工作效率和減少人工干預(yù)。智能搜索引擎:在搜索引擎中集成mPLUG-DocOwl 1.5,增強(qiáng)對圖像中文本內(nèi)容的搜索能力,提供更準(zhǔn)確的搜索結(jié)果。輔助閱讀和理解:幫助用戶更好地理解復(fù)雜文檔的內(nèi)容,尤其是對于視覺障礙人士,基于解析文檔結(jié)構(gòu)提供易于訪問的信息。教育和學(xué)術(shù)研究:在教育領(lǐng)域,輔助學(xué)生和研究人員理解教科書、學(xué)術(shù)論文和研究資料中的復(fù)雜信息。客戶服務(wù)和支持:在客戶服務(wù)系統(tǒng)中,用mPLUG-DocOwl 1.5解析用戶上傳的文檔,自動(dòng)提取關(guān)鍵信息,提供更快的服務(wù)響應(yīng)。