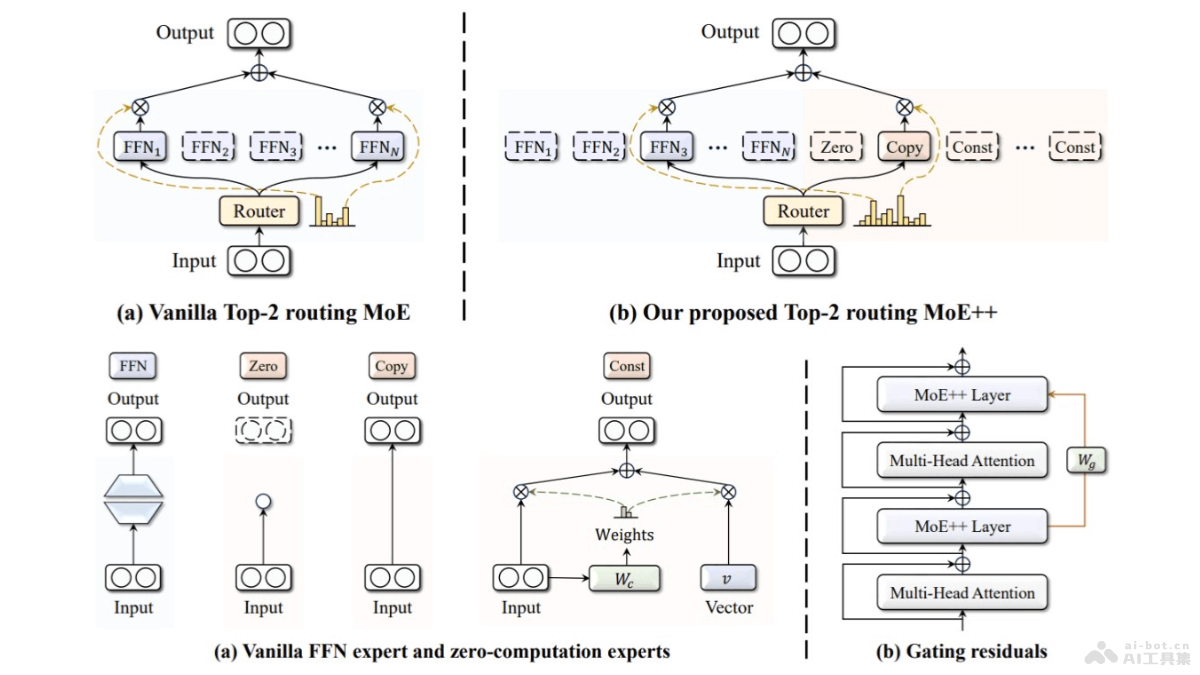

MoE++是一種新型的混合專家(Mixture-of-Experts)架構(gòu),由昆侖萬維2050研究院與北大袁粒團(tuán)隊(duì)聯(lián)合推出。基于引入零計(jì)算量專家,零專家、復(fù)制專家和常數(shù)專家,降低計(jì)算成本、提升模型性能。MoE++支持每個(gè)Token動(dòng)態(tài)地與不同數(shù)量的前饋網(wǎng)絡(luò)專家交互,甚至跳過某些層,優(yōu)化計(jì)算資源分配。MoE++基于門控殘差幫助Token在選擇專家時(shí)考慮前一層的路由路徑,實(shí)現(xiàn)更穩(wěn)定的路由。實(shí)驗(yàn)表明,MoE++在相同模型大小下比傳統(tǒng)MoE模型性能更優(yōu),專家吞吐速度提升1.1到2.1倍,且易于部署。

MoE++的主要功能降低計(jì)算成本:MoE++引入零計(jì)算量專家,支持模型中的每個(gè)Token動(dòng)態(tài)地與不同數(shù)量的前饋網(wǎng)絡(luò)(FFN)專家交互,甚至跳過某些層,減少不必要的計(jì)算。提升模型性能:減少簡(jiǎn)單Token所需的FFN專家數(shù)量,MoE++釋放出更多的專家資源專注于處理復(fù)雜的Token,提升模型的整體性能。優(yōu)化資源分配:MoE++通過靈活的計(jì)算分配,讓模型將計(jì)算資源集中在更需要的Token上,提高計(jì)算效率。穩(wěn)定路由:MoE++基于門控殘差(gating residuals)機(jī)制,讓Token在選擇專家時(shí)參考前一層的路由路徑,實(shí)現(xiàn)更穩(wěn)定的專家選擇。易于部署:由于零計(jì)算量專家的參數(shù)極小,MoE++在同一GPU上部署所有這類專家,避免分布式FFN專家部署帶來的通信開銷和負(fù)載不均問題。MoE++的技術(shù)原理零計(jì)算量專家:MoE++引入三種類型的零計(jì)算量專家,包括零專家(輸出空向量)、復(fù)制專家(將輸入直接作為輸出)、常數(shù)專家(用可訓(xùn)練的向量替代輸入)。動(dòng)態(tài)專家選擇:與傳統(tǒng)MoE方法不同,MoE++支持每個(gè)Token根據(jù)其復(fù)雜性動(dòng)態(tài)選擇不同數(shù)量的FFN專家進(jìn)行處理。門控殘差:MoE++在專家選擇過程中加入門控殘差,讓Token在選擇當(dāng)前層的專家時(shí)考慮前一層的路由路徑,增強(qiáng)模型在不同層之間的信息流動(dòng)。異構(gòu)專家結(jié)構(gòu):MoE++的專家結(jié)構(gòu)是異構(gòu)的,不同類型的專家(FFN專家和零計(jì)算量專家)在同一模型中協(xié)同工作,提高模型的適應(yīng)性和靈活性。負(fù)載平衡:MoE++基于引入負(fù)載平衡損失和專家容量分配策略,確保模型在訓(xùn)練過程中專家的負(fù)載均衡,避免某些專家過載而其他專家閑置的問題。MoE++的項(xiàng)目地址GitHub倉(cāng)庫(kù):https://github.com/SkyworkAI/MoE-plus-plusHuggingFace模型庫(kù):https://huggingface.co/Chat-UniVi/MoE-Plus-Plus-7BarXiv技術(shù)論文:https://arxiv.org/pdf/2410.07348MoE++的應(yīng)用場(chǎng)景自然語(yǔ)言處理(NLP)研究者:研究者構(gòu)建和訓(xùn)練更高效的大型語(yǔ)言模型,進(jìn)行語(yǔ)言理解、文本生成、機(jī)器翻譯、問答系統(tǒng)等研究。企業(yè)開發(fā)者:企業(yè)開發(fā)者開發(fā)高性能的NLP應(yīng)用,如智能客服、內(nèi)容推薦系統(tǒng)、自動(dòng)摘要、情感分析等,提高產(chǎn)品的智能化水平。云計(jì)算和AI服務(wù)提供商:提供商集成MoE++架構(gòu),為客戶提供更高效、成本更低的AI服務(wù),尤其是在需要處理大量語(yǔ)言數(shù)據(jù)的場(chǎng)景中。學(xué)術(shù)機(jī)構(gòu):學(xué)術(shù)機(jī)構(gòu)進(jìn)行各種NLP任務(wù)的教學(xué)和研究,幫助學(xué)生和研究人員理解先進(jìn)的深度學(xué)習(xí)模型和算法。

MoE++的主要功能降低計(jì)算成本:MoE++引入零計(jì)算量專家,支持模型中的每個(gè)Token動(dòng)態(tài)地與不同數(shù)量的前饋網(wǎng)絡(luò)(FFN)專家交互,甚至跳過某些層,減少不必要的計(jì)算。提升模型性能:減少簡(jiǎn)單Token所需的FFN專家數(shù)量,MoE++釋放出更多的專家資源專注于處理復(fù)雜的Token,提升模型的整體性能。優(yōu)化資源分配:MoE++通過靈活的計(jì)算分配,讓模型將計(jì)算資源集中在更需要的Token上,提高計(jì)算效率。穩(wěn)定路由:MoE++基于門控殘差(gating residuals)機(jī)制,讓Token在選擇專家時(shí)參考前一層的路由路徑,實(shí)現(xiàn)更穩(wěn)定的專家選擇。易于部署:由于零計(jì)算量專家的參數(shù)極小,MoE++在同一GPU上部署所有這類專家,避免分布式FFN專家部署帶來的通信開銷和負(fù)載不均問題。MoE++的技術(shù)原理零計(jì)算量專家:MoE++引入三種類型的零計(jì)算量專家,包括零專家(輸出空向量)、復(fù)制專家(將輸入直接作為輸出)、常數(shù)專家(用可訓(xùn)練的向量替代輸入)。動(dòng)態(tài)專家選擇:與傳統(tǒng)MoE方法不同,MoE++支持每個(gè)Token根據(jù)其復(fù)雜性動(dòng)態(tài)選擇不同數(shù)量的FFN專家進(jìn)行處理。門控殘差:MoE++在專家選擇過程中加入門控殘差,讓Token在選擇當(dāng)前層的專家時(shí)考慮前一層的路由路徑,增強(qiáng)模型在不同層之間的信息流動(dòng)。異構(gòu)專家結(jié)構(gòu):MoE++的專家結(jié)構(gòu)是異構(gòu)的,不同類型的專家(FFN專家和零計(jì)算量專家)在同一模型中協(xié)同工作,提高模型的適應(yīng)性和靈活性。負(fù)載平衡:MoE++基于引入負(fù)載平衡損失和專家容量分配策略,確保模型在訓(xùn)練過程中專家的負(fù)載均衡,避免某些專家過載而其他專家閑置的問題。MoE++的項(xiàng)目地址GitHub倉(cāng)庫(kù):https://github.com/SkyworkAI/MoE-plus-plusHuggingFace模型庫(kù):https://huggingface.co/Chat-UniVi/MoE-Plus-Plus-7BarXiv技術(shù)論文:https://arxiv.org/pdf/2410.07348MoE++的應(yīng)用場(chǎng)景自然語(yǔ)言處理(NLP)研究者:研究者構(gòu)建和訓(xùn)練更高效的大型語(yǔ)言模型,進(jìn)行語(yǔ)言理解、文本生成、機(jī)器翻譯、問答系統(tǒng)等研究。企業(yè)開發(fā)者:企業(yè)開發(fā)者開發(fā)高性能的NLP應(yīng)用,如智能客服、內(nèi)容推薦系統(tǒng)、自動(dòng)摘要、情感分析等,提高產(chǎn)品的智能化水平。云計(jì)算和AI服務(wù)提供商:提供商集成MoE++架構(gòu),為客戶提供更高效、成本更低的AI服務(wù),尤其是在需要處理大量語(yǔ)言數(shù)據(jù)的場(chǎng)景中。學(xué)術(shù)機(jī)構(gòu):學(xué)術(shù)機(jī)構(gòu)進(jìn)行各種NLP任務(wù)的教學(xué)和研究,幫助學(xué)生和研究人員理解先進(jìn)的深度學(xué)習(xí)模型和算法。