OmniParser是微軟研究院推出的屏幕解析工具,將用戶界面的屏幕截圖轉換成結構化數據。工具專門設計用在提高基于大型語言模型(如GPT-4V)的UI代理系統的性能,基于準確識別可交互圖標和理解截圖元素的語義,增強代理執行任務的能力。OmniParser用微調過的模型提取屏幕中的交互區域和元素功能語義,在多個基準測試中提升操作的精確度和代理的性能,無需依賴額外信息如HTML或視圖層次結構。

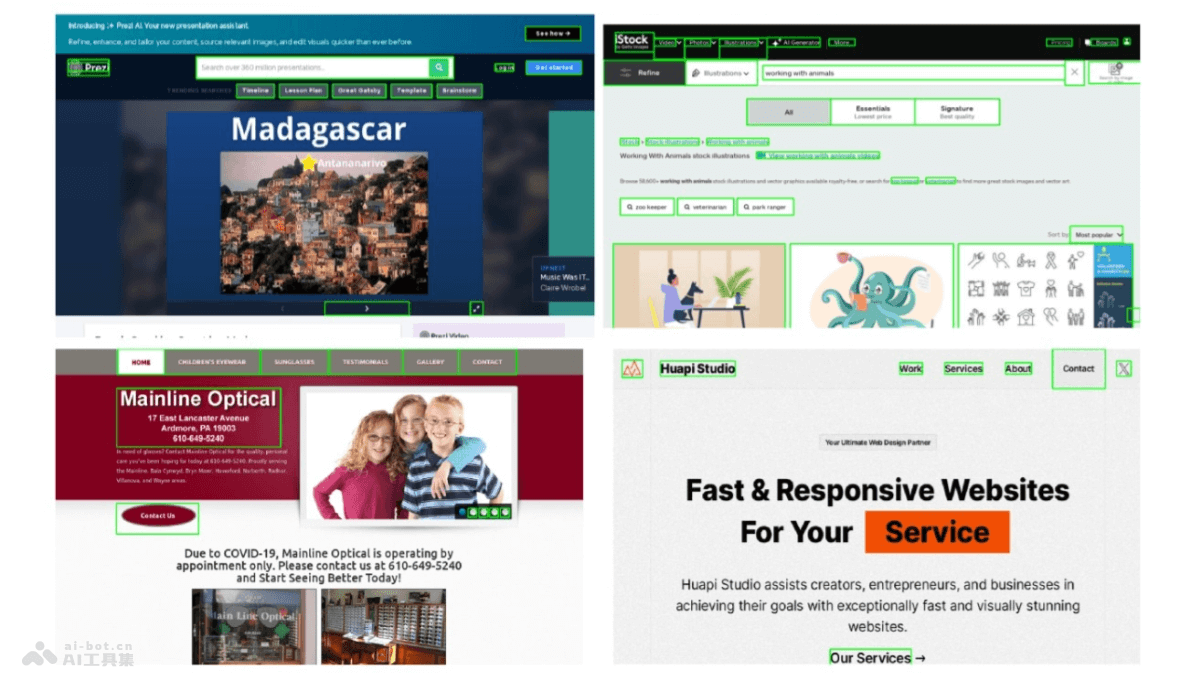

OmniParser的主要功能解析UI截圖:OmniParser將用戶界面的屏幕截圖解析成結構化的元素,包括可交互圖標和文本。識別可交互區域:用專門的檢測模型識別和標記UI中的可交互區域,如按鈕和圖標。提取功能語義:用描述模型提取檢測到的元素的功能語義,生成對用戶任務相關的描述。增強代理性能:結合解析結果,提升基于大型語言模型(如GPT-4V)的UI代理在執行任務時的性能和準確性。跨平臺應用:支持多種操作系統和應用程序,如Windows、MacOS、iOS、Android及多種Web瀏覽器和桌面應用。無需額外信息:無需依賴HTML或視圖層次結構等額外信息,獨立地從視覺截圖中提取必要數據。OmniParser的技術原理數據集構建:從流行網頁和應用中提取數據,構建可交互圖標檢測數據集和圖標描述數據集。模型微調:檢測模型:用YOLOv8模型在可交互圖標檢測數據集上進行微調,識別和定位UI中的可交互區域。描述模型:用BLIP-v2模型在圖標描述數據集上進行微調,生成圖標的功能描述。OCR模塊:集成光學字符識別(OCR)模塊提取屏幕上的文本,與圖標檢測結果合并,去除高重疊的邊界框。結構化表示:將檢測到的元素和生成的描述整合,形成結構化的DOM(文檔對象模型)表示,在潛在可交互元素上疊加邊界框的截圖。行動預測:結合結構化元素和功能語義,減輕大型語言模型在行動預測時的負擔,更準確地將預測的行動轉換為屏幕上的實際行動。OmniParser的項目地址項目官網:omniparser-for-pure-vision-based-gui-agentHuggingFace模型庫:https://huggingface.co/microsoft/OmniParserarXiv技術論文:https://arxiv.org/pdf/2408.00203OmniParser的應用場景自動化軟件測試:在軟件開發過程中,自動識別和操作UI元素,執行測試腳本,提高測試效率和覆蓋率。虛擬助手:作為虛擬助手的一部分,幫助理解屏幕內容、執行如預訂、查詢和數據輸入等任務。輔助技術:對于視覺障礙人士,OmniParser能解析屏幕內容、轉化為語音輸出,提供屏幕閱讀功能。用戶界面設計驗證:設計師驗證UI設計中的可交互元素是否符合預期的功能和語義。跨平臺應用開發:開發者在不同操作系統和設備上測試和優化應用的UI,確保一致的用戶體驗。

OmniParser的主要功能解析UI截圖:OmniParser將用戶界面的屏幕截圖解析成結構化的元素,包括可交互圖標和文本。識別可交互區域:用專門的檢測模型識別和標記UI中的可交互區域,如按鈕和圖標。提取功能語義:用描述模型提取檢測到的元素的功能語義,生成對用戶任務相關的描述。增強代理性能:結合解析結果,提升基于大型語言模型(如GPT-4V)的UI代理在執行任務時的性能和準確性。跨平臺應用:支持多種操作系統和應用程序,如Windows、MacOS、iOS、Android及多種Web瀏覽器和桌面應用。無需額外信息:無需依賴HTML或視圖層次結構等額外信息,獨立地從視覺截圖中提取必要數據。OmniParser的技術原理數據集構建:從流行網頁和應用中提取數據,構建可交互圖標檢測數據集和圖標描述數據集。模型微調:檢測模型:用YOLOv8模型在可交互圖標檢測數據集上進行微調,識別和定位UI中的可交互區域。描述模型:用BLIP-v2模型在圖標描述數據集上進行微調,生成圖標的功能描述。OCR模塊:集成光學字符識別(OCR)模塊提取屏幕上的文本,與圖標檢測結果合并,去除高重疊的邊界框。結構化表示:將檢測到的元素和生成的描述整合,形成結構化的DOM(文檔對象模型)表示,在潛在可交互元素上疊加邊界框的截圖。行動預測:結合結構化元素和功能語義,減輕大型語言模型在行動預測時的負擔,更準確地將預測的行動轉換為屏幕上的實際行動。OmniParser的項目地址項目官網:omniparser-for-pure-vision-based-gui-agentHuggingFace模型庫:https://huggingface.co/microsoft/OmniParserarXiv技術論文:https://arxiv.org/pdf/2408.00203OmniParser的應用場景自動化軟件測試:在軟件開發過程中,自動識別和操作UI元素,執行測試腳本,提高測試效率和覆蓋率。虛擬助手:作為虛擬助手的一部分,幫助理解屏幕內容、執行如預訂、查詢和數據輸入等任務。輔助技術:對于視覺障礙人士,OmniParser能解析屏幕內容、轉化為語音輸出,提供屏幕閱讀功能。用戶界面設計驗證:設計師驗證UI設計中的可交互元素是否符合預期的功能和語義。跨平臺應用開發:開發者在不同操作系統和設備上測試和優化應用的UI,確保一致的用戶體驗。