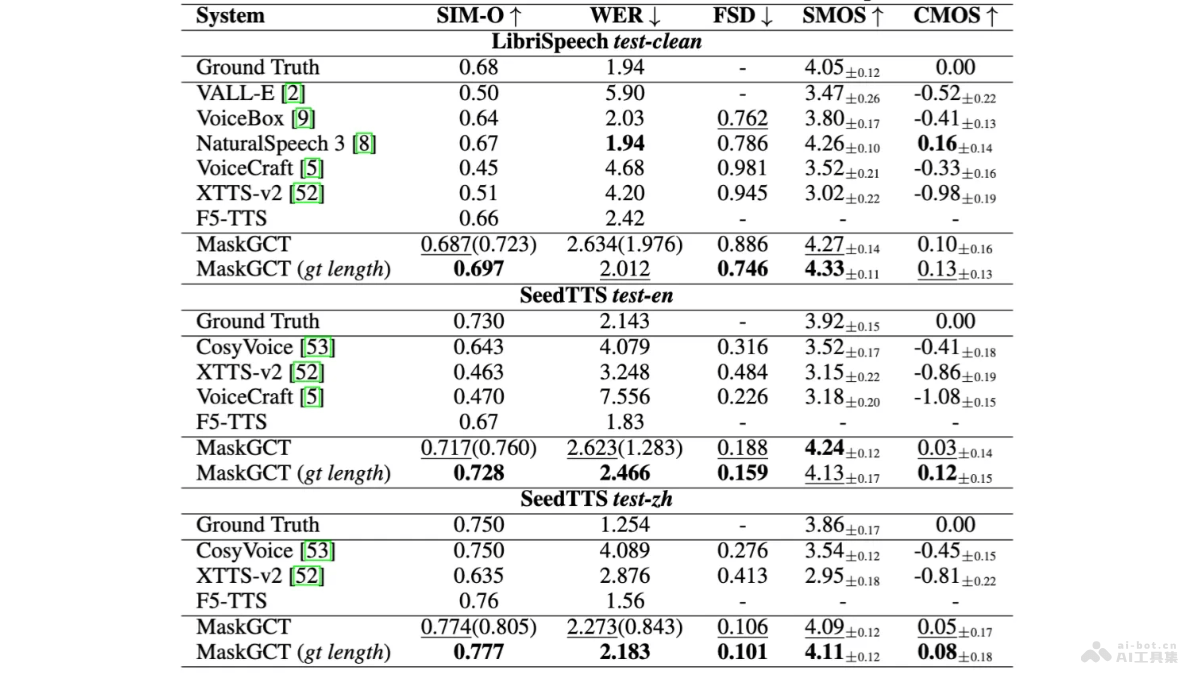

MaskGCT是趣丸科技與香港中文大學(xué)(深圳)合作推出的語音合成大模型,基于掩碼生成模型與語音表征解耦編碼的技術(shù),實(shí)現(xiàn)在聲音克隆、跨語種合成、語音控制等任務(wù)上的顯著效果。模型在多個TTS基準(zhǔn)數(shù)據(jù)集上達(dá)到行業(yè)領(lǐng)先的水平,某些性能指標(biāo)甚至超過人類。MaskGCT能快速且逼真地克隆聲音,靈活調(diào)整語音的持續(xù)時間、速度和情感,支持中文、英文、日文、韓文、法文和德文等六種語言的合成。模型已在Amphion系統(tǒng)中開源,面向全球用戶開放使用。

MaskGCT的主要功能聲音克隆:能快速復(fù)刻任意音色,包括人類、動漫角色等,且能完整地復(fù)制語調(diào)、風(fēng)格和情感。跨語種合成:支持多種語言的語音合成,包括中文、英文、日文、韓文、法文和德文等,實(shí)現(xiàn)跨語言的語音生成。語音控制:靈活調(diào)整生成語音的長度、語速和情緒,支持用編輯文本編輯語音內(nèi)容,保持韻律和音色的一致性。高質(zhì)量語音數(shù)據(jù)集:訓(xùn)練于高質(zhì)量的多語種語音數(shù)據(jù)集Emilia,提供豐富的語音合成素材。MaskGCT的技術(shù)原理語音語義表示編解碼器:將語音轉(zhuǎn)換為語義標(biāo)記,用VQ-VAE模型學(xué)習(xí)向量量化碼本,從語音自監(jiān)督學(xué)習(xí)模型中重建語音語義表示。語音聲學(xué)編解碼器:將語音波形量化為多層離散標(biāo)記,保留語音的所有信息,用RVQ方法壓縮語音波形,用Vocos架構(gòu)作為解碼器。文本到語義模型:用非自回歸掩碼生成Transformer,不依賴文本到語音的對齊信息,基于語言模型的上下文學(xué)習(xí)能力預(yù)測語義標(biāo)記。語義到聲學(xué)模型:用非自回歸掩碼生成Transformer,語義標(biāo)記為條件生成多層聲學(xué)標(biāo)記序列,重建高質(zhì)量語音波形。MaskGCT的項(xiàng)目地址GitHub倉庫:https://github.com/open-mmlab/Amphion/tree/main/models/tts/maskgctHuggingFace模型庫:https://huggingface.co/amphion/MaskGCTarXiv技術(shù)論文:https://arxiv.org/pdf/2409.00750v2公測版地址(趣丸千音):https://voice.funnycp.com/MaskGCT的應(yīng)用場景有聲讀物和播客:用MaskGCT生成的高質(zhì)量語音,為電子書、有聲讀物和播客節(jié)目提供自然的朗讀聲音,提升聽眾的聽覺體驗(yàn)。智能助手和聊天機(jī)器人:在智能設(shè)備和客服系統(tǒng)中,MaskGCT提供更加自然和個性化的語音交互體驗(yàn)。視頻游戲和虛擬現(xiàn)實(shí):在游戲和虛擬現(xiàn)實(shí)應(yīng)用中,MaskGCT為角色生成逼真的語音,增強(qiáng)沉浸感。影視制作和配音:在影視后期制作中,MaskGCT快速生成或替換角色的語音,提高制作效率。語言學(xué)習(xí)和教育:MaskGCT生成標(biāo)準(zhǔn)或特定口音的語音,輔助語言學(xué)習(xí)者練習(xí)發(fā)音和聽力。

MaskGCT的主要功能聲音克隆:能快速復(fù)刻任意音色,包括人類、動漫角色等,且能完整地復(fù)制語調(diào)、風(fēng)格和情感。跨語種合成:支持多種語言的語音合成,包括中文、英文、日文、韓文、法文和德文等,實(shí)現(xiàn)跨語言的語音生成。語音控制:靈活調(diào)整生成語音的長度、語速和情緒,支持用編輯文本編輯語音內(nèi)容,保持韻律和音色的一致性。高質(zhì)量語音數(shù)據(jù)集:訓(xùn)練于高質(zhì)量的多語種語音數(shù)據(jù)集Emilia,提供豐富的語音合成素材。MaskGCT的技術(shù)原理語音語義表示編解碼器:將語音轉(zhuǎn)換為語義標(biāo)記,用VQ-VAE模型學(xué)習(xí)向量量化碼本,從語音自監(jiān)督學(xué)習(xí)模型中重建語音語義表示。語音聲學(xué)編解碼器:將語音波形量化為多層離散標(biāo)記,保留語音的所有信息,用RVQ方法壓縮語音波形,用Vocos架構(gòu)作為解碼器。文本到語義模型:用非自回歸掩碼生成Transformer,不依賴文本到語音的對齊信息,基于語言模型的上下文學(xué)習(xí)能力預(yù)測語義標(biāo)記。語義到聲學(xué)模型:用非自回歸掩碼生成Transformer,語義標(biāo)記為條件生成多層聲學(xué)標(biāo)記序列,重建高質(zhì)量語音波形。MaskGCT的項(xiàng)目地址GitHub倉庫:https://github.com/open-mmlab/Amphion/tree/main/models/tts/maskgctHuggingFace模型庫:https://huggingface.co/amphion/MaskGCTarXiv技術(shù)論文:https://arxiv.org/pdf/2409.00750v2公測版地址(趣丸千音):https://voice.funnycp.com/MaskGCT的應(yīng)用場景有聲讀物和播客:用MaskGCT生成的高質(zhì)量語音,為電子書、有聲讀物和播客節(jié)目提供自然的朗讀聲音,提升聽眾的聽覺體驗(yàn)。智能助手和聊天機(jī)器人:在智能設(shè)備和客服系統(tǒng)中,MaskGCT提供更加自然和個性化的語音交互體驗(yàn)。視頻游戲和虛擬現(xiàn)實(shí):在游戲和虛擬現(xiàn)實(shí)應(yīng)用中,MaskGCT為角色生成逼真的語音,增強(qiáng)沉浸感。影視制作和配音:在影視后期制作中,MaskGCT快速生成或替換角色的語音,提高制作效率。語言學(xué)習(xí)和教育:MaskGCT生成標(biāo)準(zhǔn)或特定口音的語音,輔助語言學(xué)習(xí)者練習(xí)發(fā)音和聽力。