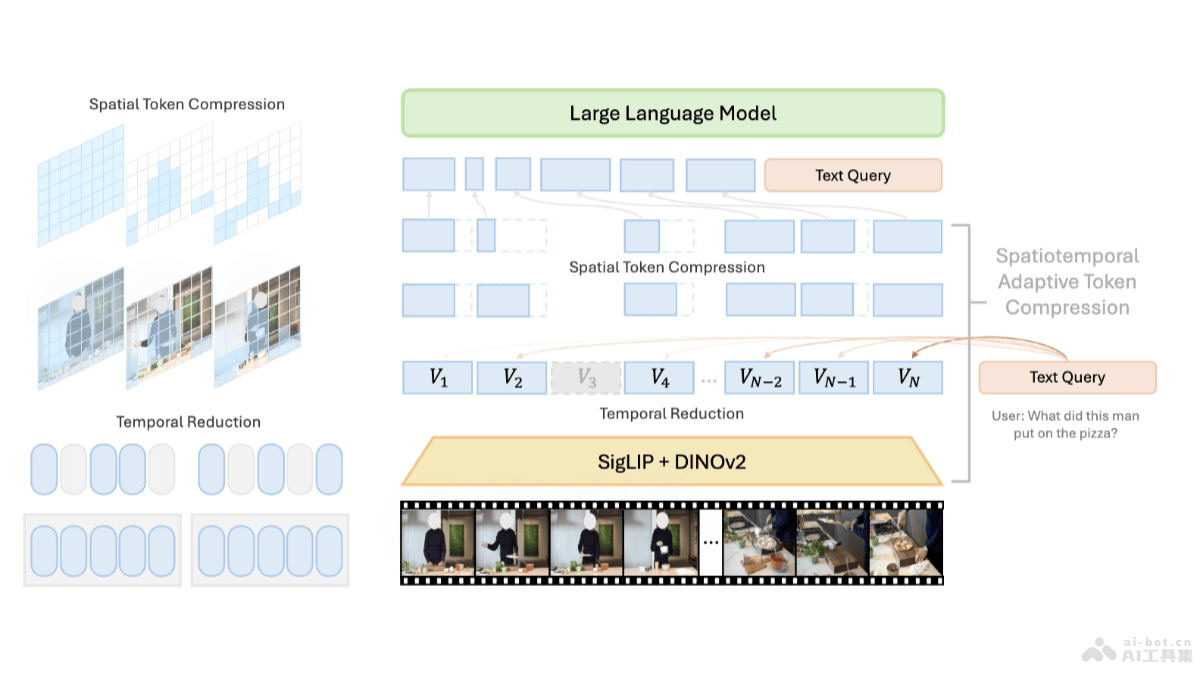

LongVU是Meta AI團隊推出的長視頻理解模型,基于時空自適應壓縮機制。解決處理長視頻時受限于大型語言模型(LLM)上下文大小的挑戰。LongVU基于跨模態查詢和幀間依賴性,LongVU能在減少視頻標記數量的同時,保留長視頻的視覺細節。LongVU用DINOv2特征去除相似度高的冗余幀,用文本引導的跨模態查詢進行選擇性幀特征減少,在必要時基于時間依賴性進行空間標記壓縮。LongVU能有效處理大量幀,在給定的上下文長度內損失很少的視覺信息。

LongVU的主要功能時空自適應壓縮:LongVU基于減少視頻標記的數量來處理長視頻,保留視頻中的關鍵視覺細節,能在有限的上下文長度內處理非常長的的視頻內容。跨模態查詢:基于文本引導的跨模態查詢來選擇性地減少視頻幀的特征,能保留與文本查詢最相關的幀的詳細信息,將其他幀減少到低分辨率的標記表示。幀間依賴性利用:基于分析視頻幀之間的時間依賴性,LongVU能基于依賴性執行空間標記的壓縮,減少模型的上下文長度需求。長視頻理解:LongVU能有效處理1fps采樣的視頻輸入,且能適應性地將每小時長視頻的平均每個幀的標記數量減少到2個,適應8k上下文長度的多模態大型語言模型(MLLM)。LongVU的技術原理時間壓縮策略:用DINOv2特征識別、去除高度相似的冗余視頻幀,減少視頻的時間維度上的冗余。選擇性特征降低:基于文本引導的跨模態查詢,對與文本查詢相關的幀保留完整的標記(tokens),對其他幀應用空間池化,減少空間維度上的冗余。空間標記壓縮:對于極長的視頻,LongVU基于幀之間的時間依賴性進一步壓縮空間標記。用計算幀間的空間標記相似性,剔除與首幀相似度過高的后續幀的空間標記,減少模型需要處理的數據量。多模態訓練:LongVU結合圖像-語言預訓練和視頻-語言微調,用大規模視頻-文本對進行訓練,提升模型在視頻理解任務中的表現。LongVU的項目地址項目官網:vision-cair.github.io/LongVUGitHub倉庫:https://github.com/Vision-CAIR/LongVUHuggingFace模型庫:https://huggingface.co/collections/Vision-CAIR/longvu-67181d2debabfc1eb050c21darXiv技術論文:https://arxiv.org/pdf/2410.17434在線體驗Demo:https://huggingface.co/spaces/Vision-CAIR/LongVULongVU的應用場景視頻內容分析:LongVU用在分析長視頻內容,提取關鍵信息,例如在監控視頻、新聞報道或紀錄片中識別重要事件和場景。視頻搜索和索引:基于理解視頻內容,LongVU幫助構建視頻搜索引擎,讓用戶用文本查詢快速定位視頻中的相關片段。視頻內容生成:LongVU用在生成視頻內容的描述、總結或字幕,提高視頻內容的可訪問性和無障礙性。視頻問答系統:LongVU支持構建視頻問答系統,用戶對視頻內容提出問題,系統能理解問題、提供準確的答案。教育和培訓:在教育領域,LongVU用在分析教學視頻,提取關鍵教學點,幫助學生更好地理解和掌握課程內容。

LongVU的主要功能時空自適應壓縮:LongVU基于減少視頻標記的數量來處理長視頻,保留視頻中的關鍵視覺細節,能在有限的上下文長度內處理非常長的的視頻內容。跨模態查詢:基于文本引導的跨模態查詢來選擇性地減少視頻幀的特征,能保留與文本查詢最相關的幀的詳細信息,將其他幀減少到低分辨率的標記表示。幀間依賴性利用:基于分析視頻幀之間的時間依賴性,LongVU能基于依賴性執行空間標記的壓縮,減少模型的上下文長度需求。長視頻理解:LongVU能有效處理1fps采樣的視頻輸入,且能適應性地將每小時長視頻的平均每個幀的標記數量減少到2個,適應8k上下文長度的多模態大型語言模型(MLLM)。LongVU的技術原理時間壓縮策略:用DINOv2特征識別、去除高度相似的冗余視頻幀,減少視頻的時間維度上的冗余。選擇性特征降低:基于文本引導的跨模態查詢,對與文本查詢相關的幀保留完整的標記(tokens),對其他幀應用空間池化,減少空間維度上的冗余。空間標記壓縮:對于極長的視頻,LongVU基于幀之間的時間依賴性進一步壓縮空間標記。用計算幀間的空間標記相似性,剔除與首幀相似度過高的后續幀的空間標記,減少模型需要處理的數據量。多模態訓練:LongVU結合圖像-語言預訓練和視頻-語言微調,用大規模視頻-文本對進行訓練,提升模型在視頻理解任務中的表現。LongVU的項目地址項目官網:vision-cair.github.io/LongVUGitHub倉庫:https://github.com/Vision-CAIR/LongVUHuggingFace模型庫:https://huggingface.co/collections/Vision-CAIR/longvu-67181d2debabfc1eb050c21darXiv技術論文:https://arxiv.org/pdf/2410.17434在線體驗Demo:https://huggingface.co/spaces/Vision-CAIR/LongVULongVU的應用場景視頻內容分析:LongVU用在分析長視頻內容,提取關鍵信息,例如在監控視頻、新聞報道或紀錄片中識別重要事件和場景。視頻搜索和索引:基于理解視頻內容,LongVU幫助構建視頻搜索引擎,讓用戶用文本查詢快速定位視頻中的相關片段。視頻內容生成:LongVU用在生成視頻內容的描述、總結或字幕,提高視頻內容的可訪問性和無障礙性。視頻問答系統:LongVU支持構建視頻問答系統,用戶對視頻內容提出問題,系統能理解問題、提供準確的答案。教育和培訓:在教育領域,LongVU用在分析教學視頻,提取關鍵教學點,幫助學生更好地理解和掌握課程內容。