MimicTalk是浙江大學和字節(jié)跳動共同研發(fā)推出基于NeRF(神經(jīng)輻射場)技術(shù),能在極短的時間內(nèi),僅需15分鐘訓練出個性化和富有表現(xiàn)力的3D說話人臉模型。MimicTalk提高了訓練效率,基于高效的微調(diào)策略和具有上下文學習能力的人臉動作生成模型,顯著提升生成視頻的質(zhì)量。MimicTalk的代碼是基于之前的Real3D-Portrait項目,進一步優(yōu)化而來,支持用音頻驅(qū)動來生成特定人物的說話頭像,讓數(shù)字人視頻在感官上與真人具有極高的相似性。

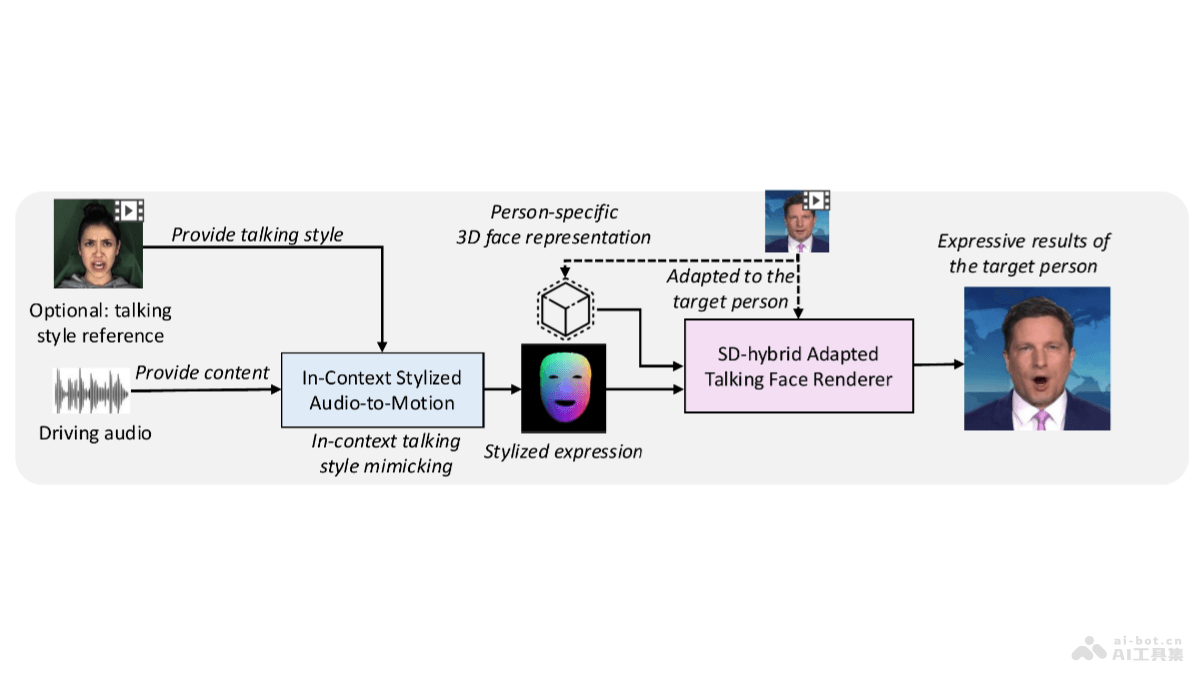

MimicTalk的主要功能快速個性化訓練:MimicTalk能在15分鐘內(nèi)完成對一個新身份的適應和訓練,相比傳統(tǒng)方法大幅提高訓練效率。高質(zhì)量視頻生成:基于精細調(diào)整和優(yōu)化,MimicTalk生成的視頻在視覺質(zhì)量上超越以往的技術(shù)。表現(xiàn)力增強:MimicTalk能捕捉和模仿目標人物的動態(tài)說話風格,讓生成的視頻更加生動和富有表現(xiàn)力。上下文學習:模型能從上下文中學習目標人的說話風格,提高面部動作的自然度和真實感。音頻驅(qū)動:支持用音頻輸入驅(qū)動特定人物的3D說話頭像,實現(xiàn)音頻到面部動作的同步。MimicTalk的技術(shù)原理人-不可知3D人臉生成模型(Person-Agnostic 3D Face Generation Model):作為基礎模型,是一個預訓練的、能處理單張圖片輸入的通用3D人臉生成模型。模型能為不同的人物身份生成逼真的3D人臉。靜態(tài)-動態(tài)混合適應流程(Static-Dynamic Hybrid Adaptation Pipeline):混合適應流程幫助模型學習特定身份的靜態(tài)外觀(如面部幾何形狀和紋理細節(jié))和動態(tài)特征(如面部表情和肌肉運動)。基于優(yōu)化3D人臉表征(tri-plane)和用低秩適應(LoRA)技術(shù),模型能快速適應新的身份。上下文風格化的音頻到運動模型(In-Context Stylized Audio-to-Motion Model, ICS-A2M):模型負責生成與目標人物說話風格相匹配的面部動作。基于上下文學習模仿參考視頻中的說話風格,無需顯式的風格表示。Flow Matching模型:用在生成表達性面部動作的先進生成模型,預測數(shù)據(jù)點的速度場,指導數(shù)據(jù)點從簡單的先驗分布向目標分布移動。在訓練中用條件流匹配(Conditional Flow Matching, CFM)目標,優(yōu)化模型預測的準確性。推理過程(Inference Process):在推理階段,MimicTalk用ICS-A2M模型和個性化渲染器生成高質(zhì)量的說話人臉視頻。推理過程涉及將音頻輸入與目標人物的參考視頻相結(jié)合,產(chǎn)生模仿特定說話風格的面部動作。數(shù)據(jù)和訓練效率:MimicTalk的設計注重樣本效率和訓練效率,能在極短的時間內(nèi)用少量數(shù)據(jù)完成新身份的適應。MimicTalk的項目地址項目官網(wǎng):mimictalk.github.ioGitHub倉庫:https://github.com/yerfor/MimicTalkarXiv技術(shù)論文:https://arxiv.org/pdf/2410.06734MimicTalk的應用場景虛擬主播和數(shù)字人:在新聞播報、娛樂節(jié)目和在線直播中,用MimicTalk技術(shù)創(chuàng)建虛擬主播,提供更加自然和吸引人的觀看體驗。視頻會議和遠程協(xié)作:在遠程工作和在線會議中,MimicTalk為用戶提供個性化的虛擬形象,增加互動性和沉浸感。虛擬現(xiàn)實(VR)和增強現(xiàn)實(AR):在VR和AR應用中,MimicTalk生成逼真的虛擬角色,提升游戲體驗和互動質(zhì)量。社交媒體和娛樂:用戶創(chuàng)建自己的虛擬形象,在社交媒體上分享,或者在虛擬世界中與他人互動。客戶服務和聊天機器人:基于MimicTalk技術(shù),開發(fā)更加人性化的客戶服務機器人,提供更加自然和親切的客戶體驗。

MimicTalk的主要功能快速個性化訓練:MimicTalk能在15分鐘內(nèi)完成對一個新身份的適應和訓練,相比傳統(tǒng)方法大幅提高訓練效率。高質(zhì)量視頻生成:基于精細調(diào)整和優(yōu)化,MimicTalk生成的視頻在視覺質(zhì)量上超越以往的技術(shù)。表現(xiàn)力增強:MimicTalk能捕捉和模仿目標人物的動態(tài)說話風格,讓生成的視頻更加生動和富有表現(xiàn)力。上下文學習:模型能從上下文中學習目標人的說話風格,提高面部動作的自然度和真實感。音頻驅(qū)動:支持用音頻輸入驅(qū)動特定人物的3D說話頭像,實現(xiàn)音頻到面部動作的同步。MimicTalk的技術(shù)原理人-不可知3D人臉生成模型(Person-Agnostic 3D Face Generation Model):作為基礎模型,是一個預訓練的、能處理單張圖片輸入的通用3D人臉生成模型。模型能為不同的人物身份生成逼真的3D人臉。靜態(tài)-動態(tài)混合適應流程(Static-Dynamic Hybrid Adaptation Pipeline):混合適應流程幫助模型學習特定身份的靜態(tài)外觀(如面部幾何形狀和紋理細節(jié))和動態(tài)特征(如面部表情和肌肉運動)。基于優(yōu)化3D人臉表征(tri-plane)和用低秩適應(LoRA)技術(shù),模型能快速適應新的身份。上下文風格化的音頻到運動模型(In-Context Stylized Audio-to-Motion Model, ICS-A2M):模型負責生成與目標人物說話風格相匹配的面部動作。基于上下文學習模仿參考視頻中的說話風格,無需顯式的風格表示。Flow Matching模型:用在生成表達性面部動作的先進生成模型,預測數(shù)據(jù)點的速度場,指導數(shù)據(jù)點從簡單的先驗分布向目標分布移動。在訓練中用條件流匹配(Conditional Flow Matching, CFM)目標,優(yōu)化模型預測的準確性。推理過程(Inference Process):在推理階段,MimicTalk用ICS-A2M模型和個性化渲染器生成高質(zhì)量的說話人臉視頻。推理過程涉及將音頻輸入與目標人物的參考視頻相結(jié)合,產(chǎn)生模仿特定說話風格的面部動作。數(shù)據(jù)和訓練效率:MimicTalk的設計注重樣本效率和訓練效率,能在極短的時間內(nèi)用少量數(shù)據(jù)完成新身份的適應。MimicTalk的項目地址項目官網(wǎng):mimictalk.github.ioGitHub倉庫:https://github.com/yerfor/MimicTalkarXiv技術(shù)論文:https://arxiv.org/pdf/2410.06734MimicTalk的應用場景虛擬主播和數(shù)字人:在新聞播報、娛樂節(jié)目和在線直播中,用MimicTalk技術(shù)創(chuàng)建虛擬主播,提供更加自然和吸引人的觀看體驗。視頻會議和遠程協(xié)作:在遠程工作和在線會議中,MimicTalk為用戶提供個性化的虛擬形象,增加互動性和沉浸感。虛擬現(xiàn)實(VR)和增強現(xiàn)實(AR):在VR和AR應用中,MimicTalk生成逼真的虛擬角色,提升游戲體驗和互動質(zhì)量。社交媒體和娛樂:用戶創(chuàng)建自己的虛擬形象,在社交媒體上分享,或者在虛擬世界中與他人互動。客戶服務和聊天機器人:基于MimicTalk技術(shù),開發(fā)更加人性化的客戶服務機器人,提供更加自然和親切的客戶體驗。