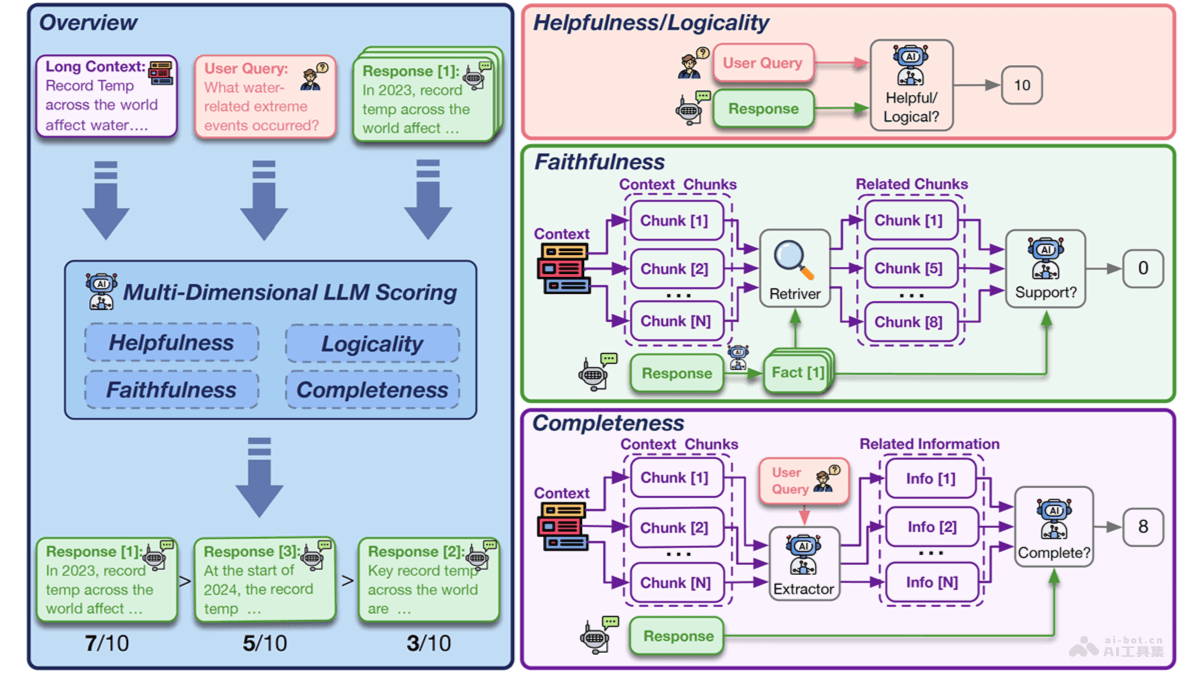

LongReward是清華大學、中國科學院、智譜AI聯合推出的,基于AI反饋改進長文本大型語言模型(LLMs)性能的方法。LongReward從有用性、邏輯性、忠實性和完整性四個維度為模型響應打分,提供獎勵信號,強化學習的方式優化模型,讓模型在處理長文本時更準確、一致,能更好地遵循指令。提升模型的長文本處理能力,增強遵循簡短指令的效率。

LongReward的主要功能多維度評分:從有用性(Helpfulness)、邏輯性(Logicality)、忠實性(Faithfulness)和完整性(Completeness)四個維度對長文本模型的響應進行評分。獎勵信號提供:用現成的大型語言模型(LLM)作為評分工具,為長文本模型的回復提供獎勵信號,信號用在強化學習(RL)。強化學習整合:結合離線強化學習算法DPO(Direct Preference Optimization),基于優化模型輸出符合偏好要求,提升模型性能。性能提升:顯著提高模型在長文本任務上的性能,包括更好地理解和利用上下文信息,減少幻覺(hallucination)現象。遵循指令能力增強:增強模型遵循簡短指令的能力,提升模型的實用性和靈活性。LongReward的技術原理多維度評估:有用性(Helpfulness):評估模型回復是否與用戶查詢相關,是否提供了有用的信息,是否滿足用戶需求。邏輯性(Logicality):檢查模型回復的邏輯一致性,包括觀點的一致性和推理的正確性。忠實性(Faithfulness):衡量模型回復中的事實信息是否與上下文一致,確保信息的真實性。完整性(Completeness):評估模型回復是否覆蓋了上下文中所有與問題相關的關鍵點,提供足夠的信息和細節。利用現成的大型語言模型(LLM):用現成的高性能LLM作為評分工具,對模型的生成內容進行評分。少樣本學習和思維鏈(Chain-of-Thought, CoT):對于有用性和邏輯性評分,基于少樣本學習和CoT讓LLM直接基于查詢和回復內容進行評分。事實性陳述分解和檢索:對于忠實性評分,將模型回復分解為事實性陳述,檢索上下文中最相關的部分判斷每個陳述是否得到支持。粗粒度上下文分解:對于完整性評分,將上下文分解為粗粒度的塊,提取與問題相關的信息,再評估模型回復是否包含所有重要信息。LongReward的項目地址GitHub倉庫:https://github.com/THUDM/LongRewardHuggingFace模型庫:https://huggingface.co/datasets/THUDM/LongReward-10karXiv技術論文:https://arxiv.org/pdf/2410.21252LongReward的應用場景長文檔理解與問答(QA):用在評估和改進模型在處理長篇文章、報告或書籍等文檔時的問答性能。文本摘要:幫助模型更好地理解和總結長篇文章或多文檔集合的主要內容。教育和學術研究:在學術研究中,LongReward用在評估和改進模型在處理大量文獻和數據時的能力,支持研究和學習。法律和金融分析:在法律和金融領域,LongReward用在分析和理解大量的法律文件、合同或金融報告。醫療記錄分析:在醫療領域,LongReward輔助模型理解和分析患者的詳細醫療記錄,支持診斷和治療決策。

LongReward的主要功能多維度評分:從有用性(Helpfulness)、邏輯性(Logicality)、忠實性(Faithfulness)和完整性(Completeness)四個維度對長文本模型的響應進行評分。獎勵信號提供:用現成的大型語言模型(LLM)作為評分工具,為長文本模型的回復提供獎勵信號,信號用在強化學習(RL)。強化學習整合:結合離線強化學習算法DPO(Direct Preference Optimization),基于優化模型輸出符合偏好要求,提升模型性能。性能提升:顯著提高模型在長文本任務上的性能,包括更好地理解和利用上下文信息,減少幻覺(hallucination)現象。遵循指令能力增強:增強模型遵循簡短指令的能力,提升模型的實用性和靈活性。LongReward的技術原理多維度評估:有用性(Helpfulness):評估模型回復是否與用戶查詢相關,是否提供了有用的信息,是否滿足用戶需求。邏輯性(Logicality):檢查模型回復的邏輯一致性,包括觀點的一致性和推理的正確性。忠實性(Faithfulness):衡量模型回復中的事實信息是否與上下文一致,確保信息的真實性。完整性(Completeness):評估模型回復是否覆蓋了上下文中所有與問題相關的關鍵點,提供足夠的信息和細節。利用現成的大型語言模型(LLM):用現成的高性能LLM作為評分工具,對模型的生成內容進行評分。少樣本學習和思維鏈(Chain-of-Thought, CoT):對于有用性和邏輯性評分,基于少樣本學習和CoT讓LLM直接基于查詢和回復內容進行評分。事實性陳述分解和檢索:對于忠實性評分,將模型回復分解為事實性陳述,檢索上下文中最相關的部分判斷每個陳述是否得到支持。粗粒度上下文分解:對于完整性評分,將上下文分解為粗粒度的塊,提取與問題相關的信息,再評估模型回復是否包含所有重要信息。LongReward的項目地址GitHub倉庫:https://github.com/THUDM/LongRewardHuggingFace模型庫:https://huggingface.co/datasets/THUDM/LongReward-10karXiv技術論文:https://arxiv.org/pdf/2410.21252LongReward的應用場景長文檔理解與問答(QA):用在評估和改進模型在處理長篇文章、報告或書籍等文檔時的問答性能。文本摘要:幫助模型更好地理解和總結長篇文章或多文檔集合的主要內容。教育和學術研究:在學術研究中,LongReward用在評估和改進模型在處理大量文獻和數據時的能力,支持研究和學習。法律和金融分析:在法律和金融領域,LongReward用在分析和理解大量的法律文件、合同或金融報告。醫療記錄分析:在醫療領域,LongReward輔助模型理解和分析患者的詳細醫療記錄,支持診斷和治療決策。