MMBench-Video是新穎的長視頻多題問答基準測試,是浙江大學、上海人工智能實驗室、上海交通大學和香港中文大學聯合推出的。MMBench-Video能全面評估大型視覺語言模型(LVLMs)在視頻理解方面的能力,用包含豐富視頻內容和細粒度能力評估的長視頻,彌補現有基準測試在時序理解和復雜任務處理方面的不足。MMBench-Video包含約600個YouTube視頻片段,覆蓋16個類別,每個視頻時長從30秒到6分鐘不等,配有由志愿者編寫的高質量問答對。基準測試用GPT-4進行自動化評估,提高準確性,與人類判斷保持一致。MMBench-Video的推出為研究人員提供了強大的工具,評估和改進視頻語言模型的能力。

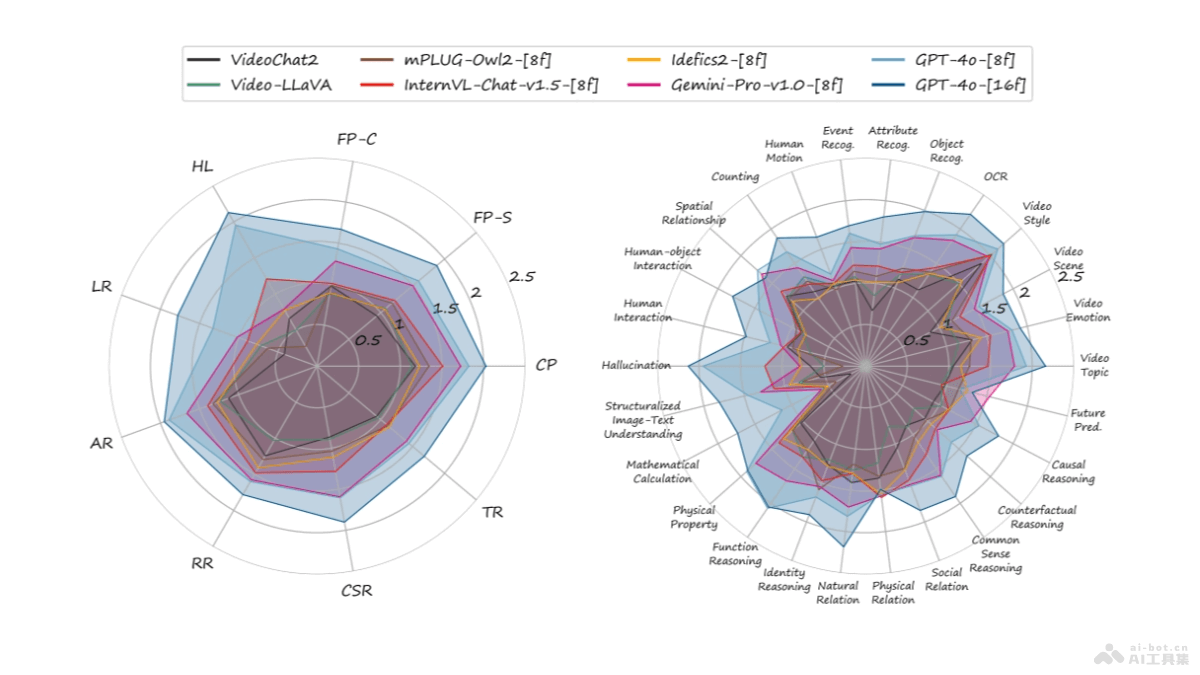

MMBench-Video的主要功能視頻理解評估:MMBench-Video用在評估大型視覺語言模型(LVLMs)在理解長視頻內容方面的能力。多場景覆蓋:包含16個主要類別的視頻內容,涵蓋廣泛的主題和場景。細粒度能力評估:用26個細粒度的能力維度,對模型的視頻理解能力進行詳盡評估。高質量數據集:視頻片段和問答對均由志愿者精心編寫和標注,確保數據質量。自動化評估:用GPT-4進行自動化的評估,提高評估的效率和準確性。MMBench-Video的技術原理長視頻內容:MMBench-Video包含從YouTube采集的多個長視頻片段,視頻片段比傳統短視頻更能測試模型的時序理解能力。人工標注:問題和答案對均由人類志愿者編寫和標注,確保高質量和減少偏差。能力分類體系:構建三層級的視頻理解能力分類體系,包括感知和推理兩大類,及更細分的26個能力維度。時序推理挑戰:設計需要時序推理能力的問題,評估模型對視頻內容時間維度的理解。自動化評估:語言模型(如GPT-4)自動化評估模型輸出與標準答案之間的語義相似度,評估模型的性能。多模型比較:支持對多個LVLMs進行評分和比較,確定在視頻理解任務上的優勢和不足。MMBench-Video的項目地址項目官網:mmbench-video.github.ioGitHub倉庫:https://github.com/open-compass/VLMEvalKitHuggingFace模型庫:https://huggingface.co/datasets/opencompass/MMBench-VideoarXiv技術論文:https://arxiv.org/pdf/2406.14515MMBench-Video的應用場景模型評估與比較:研究人員評估和比較不同的LVLMs在視頻理解方面的能力,包括感知和推理技能。模型優化與訓練:開發者根據MMBench-Video的評估結果優化模型的架構和訓練過程,提高模型對視頻內容的理解能力。學術交流與發表:作為學術交流的工具,幫助研究人員展示模型的性能,在學術會議或期刊上發表相關研究成果。多模態學習研究:MMBench-Video提供豐富的數據集,研究和開發多模態學習算法,特別是涉及視頻和文本理解的任務。智能視頻分析應用:在智能視頻監控、內容過濾、自動摘要和視頻推薦等領域,幫助開發者訓練和測試更加精準的視頻分析模型。

MMBench-Video的主要功能視頻理解評估:MMBench-Video用在評估大型視覺語言模型(LVLMs)在理解長視頻內容方面的能力。多場景覆蓋:包含16個主要類別的視頻內容,涵蓋廣泛的主題和場景。細粒度能力評估:用26個細粒度的能力維度,對模型的視頻理解能力進行詳盡評估。高質量數據集:視頻片段和問答對均由志愿者精心編寫和標注,確保數據質量。自動化評估:用GPT-4進行自動化的評估,提高評估的效率和準確性。MMBench-Video的技術原理長視頻內容:MMBench-Video包含從YouTube采集的多個長視頻片段,視頻片段比傳統短視頻更能測試模型的時序理解能力。人工標注:問題和答案對均由人類志愿者編寫和標注,確保高質量和減少偏差。能力分類體系:構建三層級的視頻理解能力分類體系,包括感知和推理兩大類,及更細分的26個能力維度。時序推理挑戰:設計需要時序推理能力的問題,評估模型對視頻內容時間維度的理解。自動化評估:語言模型(如GPT-4)自動化評估模型輸出與標準答案之間的語義相似度,評估模型的性能。多模型比較:支持對多個LVLMs進行評分和比較,確定在視頻理解任務上的優勢和不足。MMBench-Video的項目地址項目官網:mmbench-video.github.ioGitHub倉庫:https://github.com/open-compass/VLMEvalKitHuggingFace模型庫:https://huggingface.co/datasets/opencompass/MMBench-VideoarXiv技術論文:https://arxiv.org/pdf/2406.14515MMBench-Video的應用場景模型評估與比較:研究人員評估和比較不同的LVLMs在視頻理解方面的能力,包括感知和推理技能。模型優化與訓練:開發者根據MMBench-Video的評估結果優化模型的架構和訓練過程,提高模型對視頻內容的理解能力。學術交流與發表:作為學術交流的工具,幫助研究人員展示模型的性能,在學術會議或期刊上發表相關研究成果。多模態學習研究:MMBench-Video提供豐富的數據集,研究和開發多模態學習算法,特別是涉及視頻和文本理解的任務。智能視頻分析應用:在智能視頻監控、內容過濾、自動摘要和視頻推薦等領域,幫助開發者訓練和測試更加精準的視頻分析模型。