商湯科技與南洋理工大學S-Lab聯(lián)合發(fā)布并開源全新多模態(tài)模型架構(gòu)NEO,通過底層架構(gòu)創(chuàng)新實現(xiàn)視覺與語言的深層統(tǒng)一,在性能、效率和通用性上取得全面突破。

極致數(shù)據(jù)效率:1/10數(shù)據(jù)量達頂尖性能NEO最顯著的突破在于其極高的數(shù)據(jù)效率——僅需3.9億圖像文本示例,相當于業(yè)界同等性能模型1/10的數(shù)據(jù)量,便能開發(fā)出頂尖的視覺感知能力。無需依賴海量數(shù)據(jù)及額外視覺編碼器,NEO憑借簡潔架構(gòu)在多項視覺理解任務(wù)中追平Qwen2-VL、InternVL3等頂級模塊化旗艦?zāi)P汀?/p>

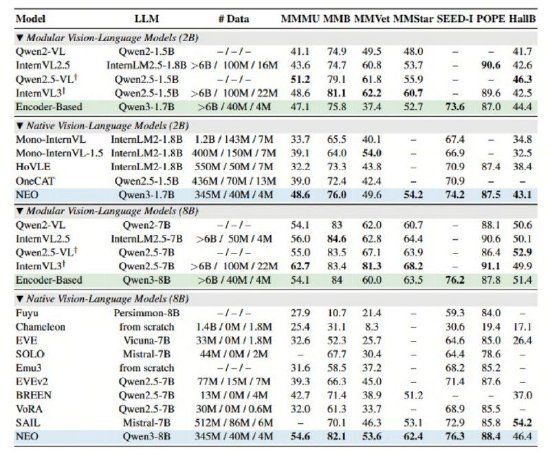

在MMMU、MMB、MMStar、SEED-I、POPE等多項公開權(quán)威評測中,NEO均斬獲高分,綜合性能優(yōu)于其他原生VLM,真正實現(xiàn)了原生架構(gòu)"精度無損"。

當前業(yè)內(nèi)主流多模態(tài)模型大多遵循"視覺編碼器+投影器+語言模型"的模塊化范式。這種基于大語言模型的擴展方式雖然實現(xiàn)了圖像輸入兼容,但本質(zhì)上仍以語言為中心,圖像與語言的融合僅停留在數(shù)據(jù)層面。這種"拼湊"式設(shè)計不僅學習效率低下,更限制了模型在復雜多模態(tài)場景下的處理能力,尤其是涉及圖像細節(jié)捕捉或復雜空間結(jié)構(gòu)理解的任務(wù)。

NEO則通過在注意力機制、位置編碼和語義映射三個關(guān)鍵維度的底層創(chuàng)新,讓模型天生具備統(tǒng)一處理視覺與語言的能力。

兩大核心技術(shù)創(chuàng)新原生圖塊嵌入(Native Patch Embedding):NEO摒棄了離散的圖像tokenizer,通過獨創(chuàng)的Patch Embedding Layer(PEL)自底向上構(gòu)建從像素到詞元的連續(xù)映射。這種設(shè)計能更精細地捕捉圖像細節(jié),從根本上突破了主流模型的圖像建模瓶頸。

原生多頭注意力(Native Multi-Head Attention):針對不同模態(tài)特點,NEO在統(tǒng)一框架下實現(xiàn)了文本token的自回歸注意力和視覺token的雙向注意力并存。這種設(shè)計極大提升了模型對空間結(jié)構(gòu)關(guān)聯(lián)的利用率,從而更好地支撐復雜的圖文混合理解與推理。