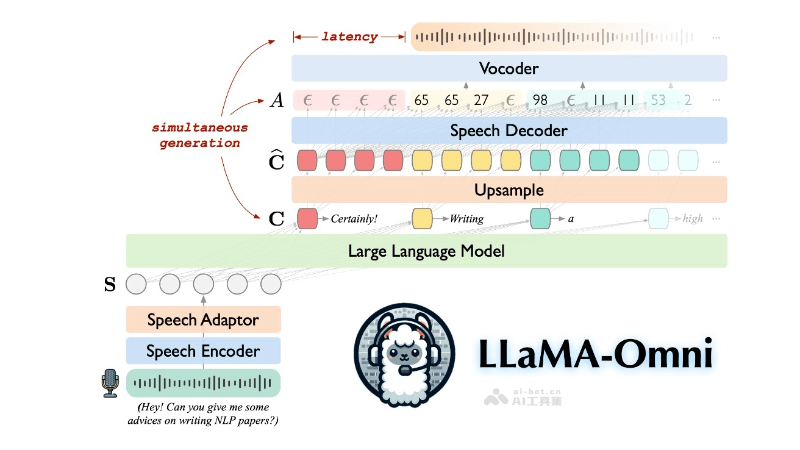

LLaMA-Omni 是中國科學(xué)院計(jì)算技術(shù)研究所和中國科學(xué)院大學(xué)研究者推出的新型模型架構(gòu),用于實(shí)現(xiàn)與大型語言模型(LLM)的低延遲、高質(zhì)量語音交互。通過集成預(yù)訓(xùn)練的語音編碼器、語音適配器、大型語言模型(LLM)和一個(gè)實(shí)時(shí)語音解碼器,直接從語音指令中快速生成文本和語音響應(yīng),省略傳統(tǒng)的必須先將語音轉(zhuǎn)錄為文本的步驟,提高了響應(yīng)速度。模型基于最新的 LLaMA-3.1-8B-Instruct 模型構(gòu)建,并使用自建的 InstructS2S-200K 數(shù)據(jù)集進(jìn)行訓(xùn)練,快速生成響應(yīng),延遲低至 226 毫秒。此外,LLaMA-Omni 的訓(xùn)練效率高,4 個(gè) GPU 訓(xùn)練不到 3 天即可完成,為未來基于最新 LLM 的語音交互模型的高效開發(fā)奠定基礎(chǔ)。

LLaMA-Omni的主要功能低延遲語音識(shí)別:快速從語音指令中生成響應(yīng),減少等待時(shí)間。直接語音到文本響應(yīng):無需先將語音轉(zhuǎn)錄為文本,直接生成文本響應(yīng)。高質(zhì)量的語音合成:生成文本響應(yīng)的同時(shí),能生成對應(yīng)的語音輸出。高效的訓(xùn)練過程:用較少的計(jì)算資源(如4個(gè)GPU)和較短的時(shí)間(不到3天)完成訓(xùn)練。流式語音解碼:基于非自回歸的流式 Transformer 模型,實(shí)現(xiàn)實(shí)時(shí)語音合成。多模態(tài)交互:結(jié)合文本和語音兩種模式,提供更自然、更人性化的交互體驗(yàn)。LLaMA-Omni的技術(shù)原理語音編碼器(Speech Encoder):基于預(yù)訓(xùn)練的 Whisper-large-v3 模型作為語音編碼器。從用戶的語音指令中提取特征表示。語音適配器(Speech Adaptor):將語音編碼器的輸出映射到大型語言模型(LLM)的嵌入空間。通過下采樣減少序列長度,使模型處理語音輸入。大型語言模型(Large Language Model, LLM):基于 Llama-3.1-8B-Instruct 作為 LLM,具有強(qiáng)大的文本生成能力。直接從語音指令生成文本響應(yīng),無需中間的語音到文本轉(zhuǎn)錄步驟。流式語音解碼器(Streaming Speech Decoder):采用非自回歸(NAR)的流式 Transformer 架構(gòu)。用連接時(shí)序分類(CTC)預(yù)測與語音響應(yīng)相對應(yīng)的離散單元序列。兩階段訓(xùn)練策略:第一階段:訓(xùn)練模型直接從語音指令生成文本響應(yīng)。第二階段:訓(xùn)練模型生成語音響應(yīng)。數(shù)據(jù)集構(gòu)建(InstructS2S-200K):包含 200K 條語音指令及對應(yīng)的文本和語音響應(yīng)。基于訓(xùn)練模型適應(yīng)語音交互場景。LLaMA-Omni的項(xiàng)目地址GitHub倉庫:https://github.com/ictnlp/LLaMA-OmniHuggingFace模型庫:https://huggingface.co/ICTNLP/Llama-3.1-8B-OmniarXiv技術(shù)論文:https://arxiv.org/pdf/2409.06666LLaMA-Omni的應(yīng)用場景智能助手和虛擬助手:在智能手機(jī)、智能家居設(shè)備和個(gè)人電腦上提供語音交互服務(wù)。客戶服務(wù):在呼叫中心和客戶支持系統(tǒng)中,用于語音識(shí)別和響應(yīng)來處理客戶咨詢和問題。教育和培訓(xùn):提供語音交互式的學(xué)習(xí)體驗(yàn),包括語言學(xué)習(xí)、課程講解和互動(dòng)式教學(xué)。醫(yī)療咨詢:在遠(yuǎn)程醫(yī)療和健康咨詢中,用語音交互提供醫(yī)療信息和建議。汽車行業(yè):集成到車載系統(tǒng)中,提供語音控制的導(dǎo)航、娛樂和通信功能。訪問性和輔助技術(shù):幫助視障或行動(dòng)不便的用戶用語音交互操作設(shè)備和服務(wù)。

LLaMA-Omni的主要功能低延遲語音識(shí)別:快速從語音指令中生成響應(yīng),減少等待時(shí)間。直接語音到文本響應(yīng):無需先將語音轉(zhuǎn)錄為文本,直接生成文本響應(yīng)。高質(zhì)量的語音合成:生成文本響應(yīng)的同時(shí),能生成對應(yīng)的語音輸出。高效的訓(xùn)練過程:用較少的計(jì)算資源(如4個(gè)GPU)和較短的時(shí)間(不到3天)完成訓(xùn)練。流式語音解碼:基于非自回歸的流式 Transformer 模型,實(shí)現(xiàn)實(shí)時(shí)語音合成。多模態(tài)交互:結(jié)合文本和語音兩種模式,提供更自然、更人性化的交互體驗(yàn)。LLaMA-Omni的技術(shù)原理語音編碼器(Speech Encoder):基于預(yù)訓(xùn)練的 Whisper-large-v3 模型作為語音編碼器。從用戶的語音指令中提取特征表示。語音適配器(Speech Adaptor):將語音編碼器的輸出映射到大型語言模型(LLM)的嵌入空間。通過下采樣減少序列長度,使模型處理語音輸入。大型語言模型(Large Language Model, LLM):基于 Llama-3.1-8B-Instruct 作為 LLM,具有強(qiáng)大的文本生成能力。直接從語音指令生成文本響應(yīng),無需中間的語音到文本轉(zhuǎn)錄步驟。流式語音解碼器(Streaming Speech Decoder):采用非自回歸(NAR)的流式 Transformer 架構(gòu)。用連接時(shí)序分類(CTC)預(yù)測與語音響應(yīng)相對應(yīng)的離散單元序列。兩階段訓(xùn)練策略:第一階段:訓(xùn)練模型直接從語音指令生成文本響應(yīng)。第二階段:訓(xùn)練模型生成語音響應(yīng)。數(shù)據(jù)集構(gòu)建(InstructS2S-200K):包含 200K 條語音指令及對應(yīng)的文本和語音響應(yīng)。基于訓(xùn)練模型適應(yīng)語音交互場景。LLaMA-Omni的項(xiàng)目地址GitHub倉庫:https://github.com/ictnlp/LLaMA-OmniHuggingFace模型庫:https://huggingface.co/ICTNLP/Llama-3.1-8B-OmniarXiv技術(shù)論文:https://arxiv.org/pdf/2409.06666LLaMA-Omni的應(yīng)用場景智能助手和虛擬助手:在智能手機(jī)、智能家居設(shè)備和個(gè)人電腦上提供語音交互服務(wù)。客戶服務(wù):在呼叫中心和客戶支持系統(tǒng)中,用于語音識(shí)別和響應(yīng)來處理客戶咨詢和問題。教育和培訓(xùn):提供語音交互式的學(xué)習(xí)體驗(yàn),包括語言學(xué)習(xí)、課程講解和互動(dòng)式教學(xué)。醫(yī)療咨詢:在遠(yuǎn)程醫(yī)療和健康咨詢中,用語音交互提供醫(yī)療信息和建議。汽車行業(yè):集成到車載系統(tǒng)中,提供語音控制的導(dǎo)航、娛樂和通信功能。訪問性和輔助技術(shù):幫助視障或行動(dòng)不便的用戶用語音交互操作設(shè)備和服務(wù)。