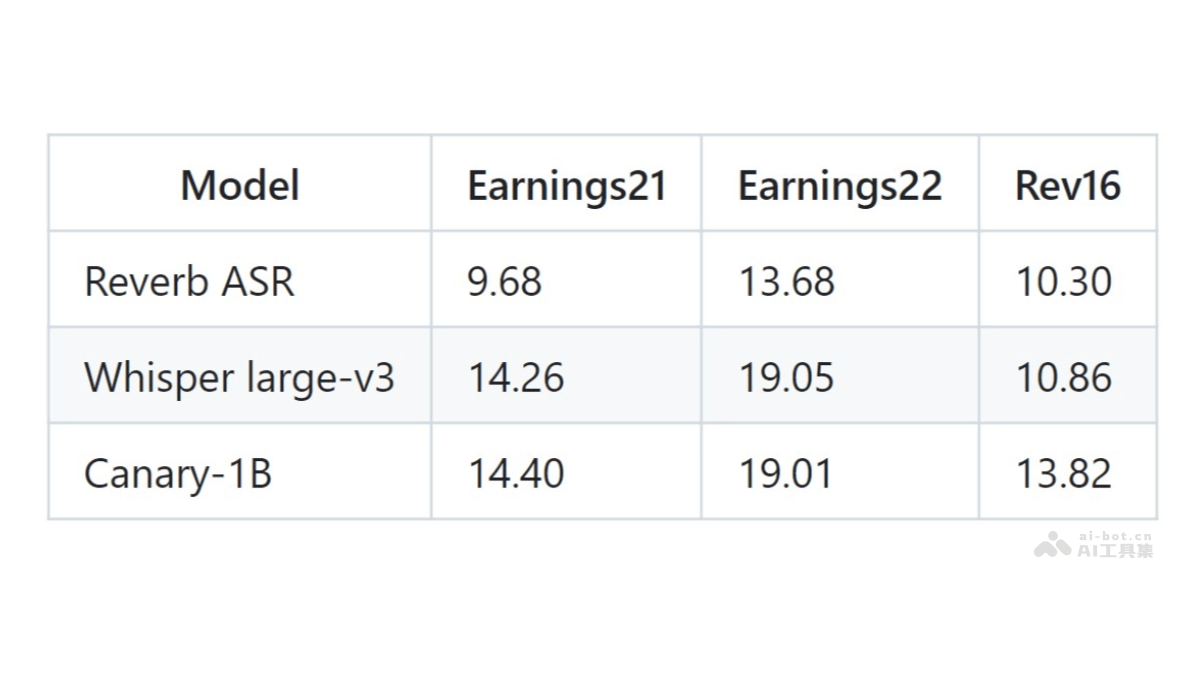

Reverb ASR是Rev公司推出的開源自動語音識別和說話人分離模型,基于20萬小時的人工轉錄英語數據訓練而成。模型在長語音識別領域表現卓越,適合處理如播客和財報電話會議等場景。Reverb ASR支持用戶控制輸出文本的逐字程度,支持從完全逐字到非逐字的不同風格,滿足精確轉錄和提高可讀性的需求。Reverb ASR提供多種解碼模式,包括注意力解碼和CTC前綴束搜索,適應不同的識別任務。在長篇幅語音識別方面,Reverb ASR的性能超過現有的開源模型,如OpenAI的Whisper和NVIDIA的Canary-1B。

Reverb ASR的主要功能高精度語音識別:Reverb ASR將英語語音高效準確地轉換成文本。逐字稿控制:用戶根據需要調整輸出的逐字稿程度,從完全逐字到非逐字,適應不同的使用場景。多種解碼模式:支持注意力解碼、CTC貪婪搜索、CTC前綴束搜索、注意力重分和聯合解碼等多種解碼模式。長篇幅語音處理:擅長處理長時間的語音輸入,如播客、會議記錄等。說話人分離:說話人分離技術,有助于區分和識別不同說話人。Reverb ASR的技術原理數據集:Reverb ASR的訓練數據集由20萬小時的英語語音組成,語音由人類專家轉錄,涵蓋多種領域、口音和錄音條件。聯合CTC/注意力架構:Reverb ASR基于結合連接時序分類(CTC)和注意力機制的架構。支持模型在識別語音時同時考慮語音的序列特性和上下文信息。編碼器-解碼器結構:模型用18層的卷積編碼器和6層的雙向注意力解碼器,有助于模型捕捉長期依賴關系和短時語音特征。語言特定層:Reverb ASR在編碼器和解碼器的第一層和最后一層用語言特定層,便于控制輸出的逐字程度。模型量化:提供Int8量化版本的ASR模型,提高模型的推斷速度,減少內存使用,適于對速度和內存敏感的應用。多種解碼模式:Reverb ASR支持多種解碼模式,包括貪婪CTC解碼、CTC前綴束搜索(帶或不帶注意力重分)、注意力解碼和聯合CTC/注意力解碼。Reverb ASR的項目地址GitHub倉庫:https://github.com/revdotcom/reverb/tree/main/asrHuggingFace在線體驗Demo:https://huggingface.co/spaces/Revai/reverb-asr-demoarXiv技術論文:https://arxiv.org/pdf/2410.03930v1Reverb ASR的應用場景播客制作:自動轉錄播客內容,便于編輯和內容管理。會議記錄:在商務會議或學術研討會中,實時生成會議記錄。法庭記錄:提供準確的法庭審理過程記錄,確保法律程序的準確性。語音內容創作:幫助內容創作者將語音轉換成文本,提高工作效率。語言學習:輔助語言學習者進行發音和聽力練習,提供實時反饋。媒體監控:監控廣播、電視或其他媒體的語音內容,便于新聞分析或輿情監控。客戶服務:在呼叫中心自動記錄和分析客戶對話,提高服務質量。

Reverb ASR的主要功能高精度語音識別:Reverb ASR將英語語音高效準確地轉換成文本。逐字稿控制:用戶根據需要調整輸出的逐字稿程度,從完全逐字到非逐字,適應不同的使用場景。多種解碼模式:支持注意力解碼、CTC貪婪搜索、CTC前綴束搜索、注意力重分和聯合解碼等多種解碼模式。長篇幅語音處理:擅長處理長時間的語音輸入,如播客、會議記錄等。說話人分離:說話人分離技術,有助于區分和識別不同說話人。Reverb ASR的技術原理數據集:Reverb ASR的訓練數據集由20萬小時的英語語音組成,語音由人類專家轉錄,涵蓋多種領域、口音和錄音條件。聯合CTC/注意力架構:Reverb ASR基于結合連接時序分類(CTC)和注意力機制的架構。支持模型在識別語音時同時考慮語音的序列特性和上下文信息。編碼器-解碼器結構:模型用18層的卷積編碼器和6層的雙向注意力解碼器,有助于模型捕捉長期依賴關系和短時語音特征。語言特定層:Reverb ASR在編碼器和解碼器的第一層和最后一層用語言特定層,便于控制輸出的逐字程度。模型量化:提供Int8量化版本的ASR模型,提高模型的推斷速度,減少內存使用,適于對速度和內存敏感的應用。多種解碼模式:Reverb ASR支持多種解碼模式,包括貪婪CTC解碼、CTC前綴束搜索(帶或不帶注意力重分)、注意力解碼和聯合CTC/注意力解碼。Reverb ASR的項目地址GitHub倉庫:https://github.com/revdotcom/reverb/tree/main/asrHuggingFace在線體驗Demo:https://huggingface.co/spaces/Revai/reverb-asr-demoarXiv技術論文:https://arxiv.org/pdf/2410.03930v1Reverb ASR的應用場景播客制作:自動轉錄播客內容,便于編輯和內容管理。會議記錄:在商務會議或學術研討會中,實時生成會議記錄。法庭記錄:提供準確的法庭審理過程記錄,確保法律程序的準確性。語音內容創作:幫助內容創作者將語音轉換成文本,提高工作效率。語言學習:輔助語言學習者進行發音和聽力練習,提供實時反饋。媒體監控:監控廣播、電視或其他媒體的語音內容,便于新聞分析或輿情監控。客戶服務:在呼叫中心自動記錄和分析客戶對話,提高服務質量。