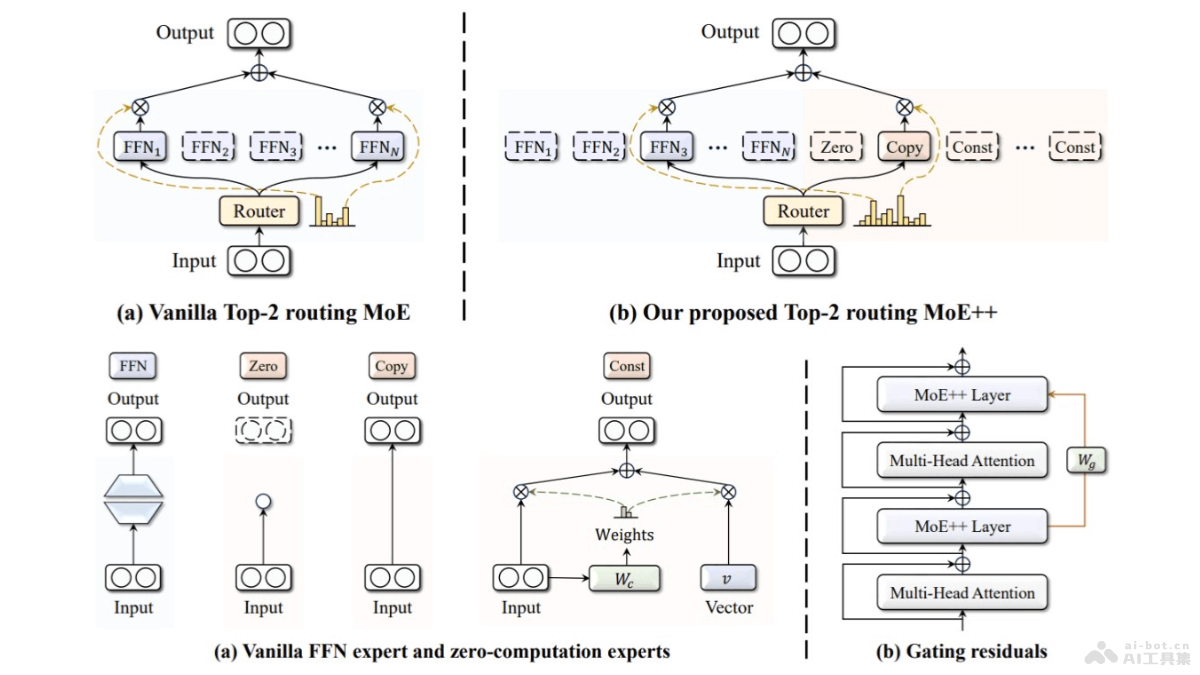

MoE++是一種新型的混合專家(Mixture-of-Experts)架構(gòu),由昆侖萬(wàn)維2050研究院與北大袁粒團(tuán)隊(duì)聯(lián)合推出。基于引入零計(jì)算量專家,即零專家、復(fù)制專家和常數(shù)專家,降低計(jì)算成本、提升模型性能。MoE++支持每個(gè)T...

-

-

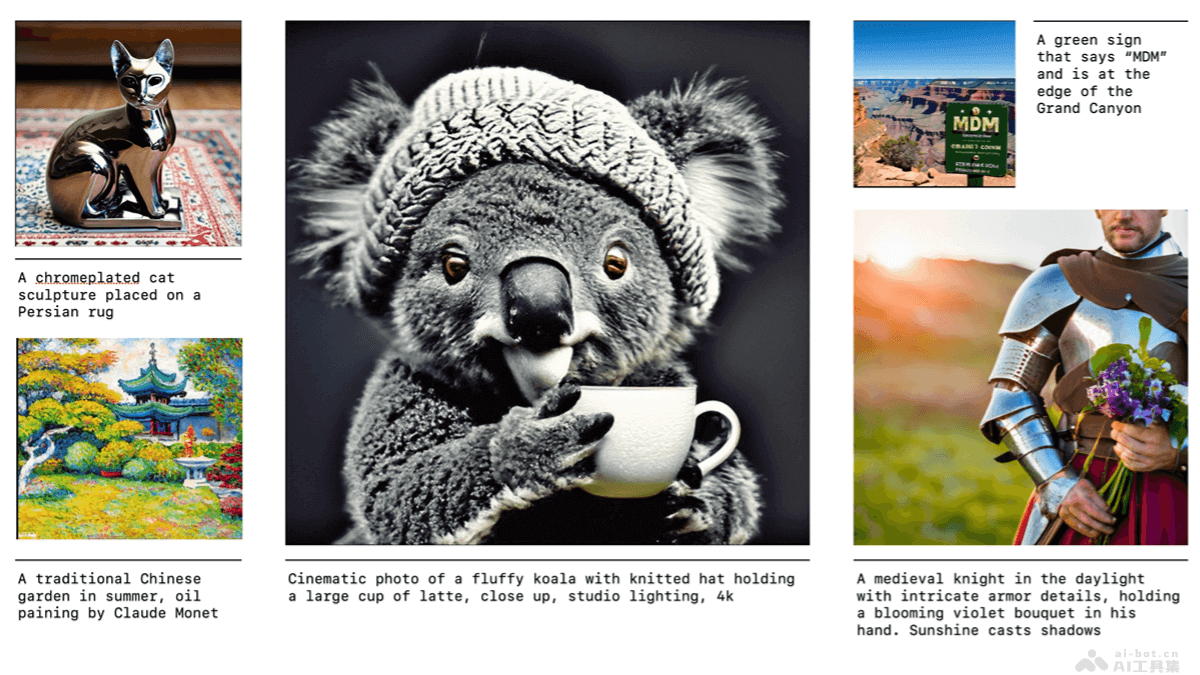

Fluid是由Google DeepMind和MIT共同推出的文本到圖像的自回歸生成模型,基于連續(xù)標(biāo)記和隨機(jī)生成順序的方法,在視覺(jué)質(zhì)量和評(píng)估性能上取得突破性進(jìn)展。模型在擴(kuò)大模型規(guī)模時(shí),能有效提升圖像生成的視覺(jué)質(zhì)量,解決傳統(tǒng)自...

-

SaRA是一種新型的預(yù)訓(xùn)練擴(kuò)散模型微調(diào)方法,由上海交通大學(xué)和騰訊優(yōu)圖實(shí)驗(yàn)室共同推出。基于重新激活預(yù)訓(xùn)練過(guò)程中看似無(wú)效的參數(shù),讓模型能適應(yīng)新任務(wù)。SaRA基于核范數(shù)低秩稀疏訓(xùn)練方案避免過(guò)擬合,引入漸進(jìn)式參數(shù)調(diào)整策略,優(yōu)化模型性...

-

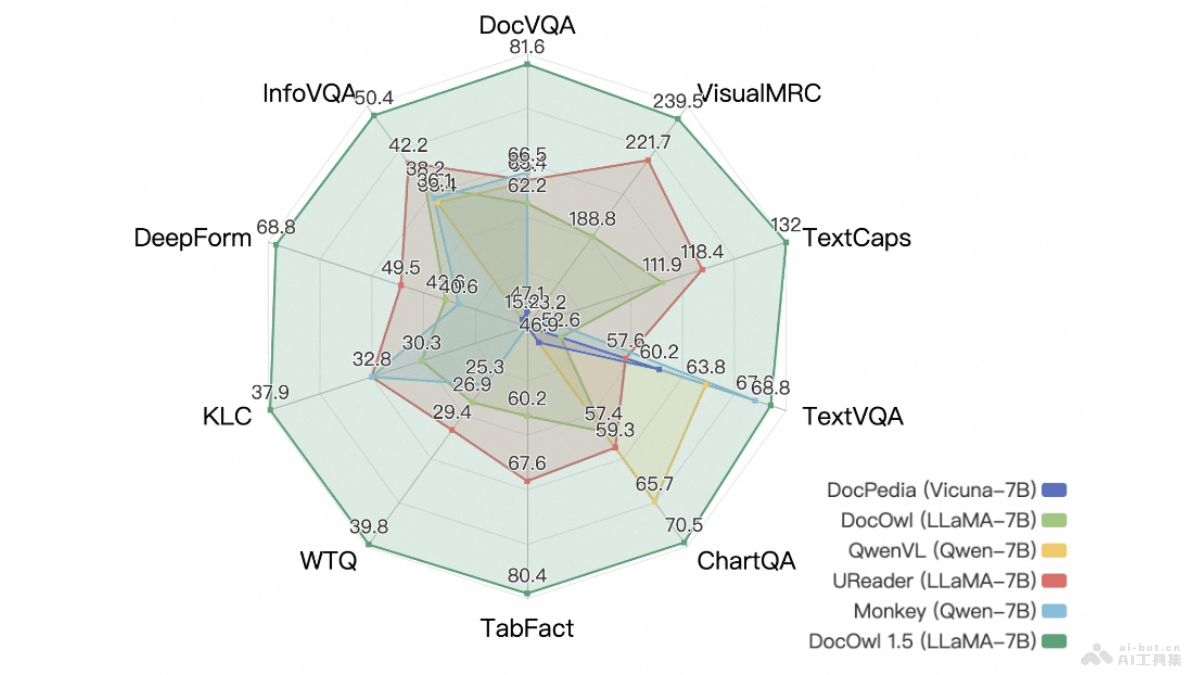

mPLUG-DocOwl 1.5是由阿里巴巴集團(tuán)推出的多模態(tài)大型語(yǔ)言模型,專注于OCR-free(無(wú)需光學(xué)字符識(shí)別)的文檔理解。模型基于統(tǒng)一結(jié)構(gòu)學(xué)習(xí),強(qiáng)化對(duì)文本豐富圖像如文檔、表格和圖表的結(jié)構(gòu)信息理解能力。...

-

Matryoshka Diffusion Models(MDM)是由蘋(píng)果公司研究人員推出的一種新型擴(kuò)散模型框架,旨在解決生成高分辨率圖像和視頻時(shí)面臨的計(jì)算和優(yōu)化挑戰(zhàn)。MDM基于在多個(gè)分辨率上聯(lián)合去噪的擴(kuò)散過(guò)程,采用嵌套UNe...

-

PDFtoChat 是一個(gè)開(kāi)源的創(chuàng)新AI項(xiàng)目,支持用戶基于自然語(yǔ)言對(duì)話的方式與 PDF 文件互動(dòng)。工具基于最新的 AI 技術(shù),包括 Together AI 和 Mixtral,理解用戶的查詢,從 PDF 內(nèi)容中提取相關(guān)信息。...

-

TurboSeek是一個(gè)開(kāi)源的AI搜索引擎,由Together.ai提供技術(shù)支持。基于現(xiàn)代化的技術(shù)棧,包括Next.js、Tailwind、Bing搜索API及先進(jìn)的語(yǔ)言模型Mixtral 8x7B和Llama-3,為用戶提...

-

Napkins.dev是一個(gè)創(chuàng)新的開(kāi)源項(xiàng)目,基于AI技術(shù)將用戶的截圖或線框圖快速轉(zhuǎn)換成可運(yùn)行的網(wǎng)頁(yè)應(yīng)用程序。該、項(xiàng)目背后依托于Meta的Llama 3.1 405B大型語(yǔ)言模型和Llama 3.2 Vision視覺(jué)模型,結(jié)合...

-

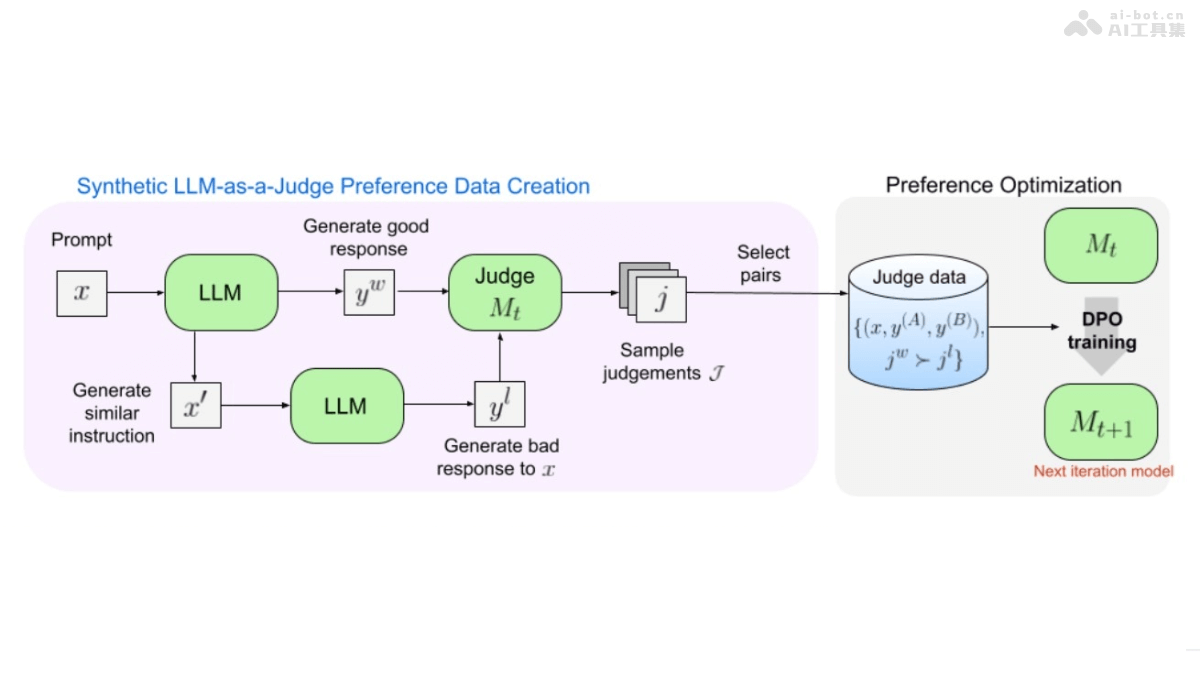

Self-Taught Evaluators是一種新型的模型評(píng)估方法,基于自我訓(xùn)練的方式提高大型語(yǔ)言模型(LLM)的評(píng)估能力,無(wú)需人工標(biāo)注數(shù)據(jù)。從未經(jīng)標(biāo)記的指令開(kāi)始,用迭代自我改進(jìn)方案生成對(duì)比模型輸出。用LLM作為裁判,生成...

-

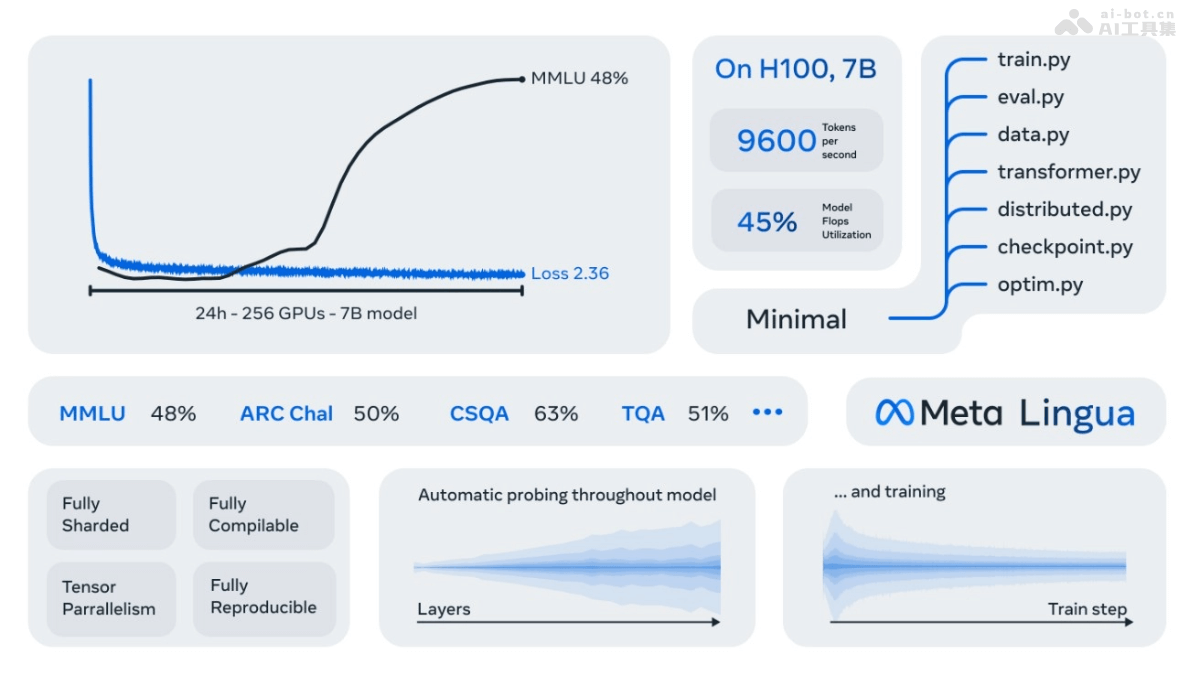

Lingua 是 Meta AI推出的一個(gè)輕量級(jí)且獨(dú)立的代碼庫(kù),旨在助力大規(guī)模訓(xùn)練語(yǔ)言模型。基于易于修改的 PyTorch 組件,便于研究人員嘗試新的模型架構(gòu)、損失函數(shù)和數(shù)據(jù)集。Lingua 專注于端到端訓(xùn)練、推理和評(píng)估,提...